مرکزدادهٔ «پروژهٔ مرکوری» شرکت eBay ـ[1]

آنچه میخوانید

شرکت eBay مرکزدادهٔ پیشروی «پروژهٔ مرکوری» را برای فروشگاه آنلاین خودش ساخته است. این تاسیسات که ظاهر ویژه و جذابی دارد، از نظر فنی چشمگیر است: ماژولار، پرظرفیت، بهرهور، با زیرساخت چند کلاسه، سرمایش با آب در کنار سرمایش با هوا، دارای سقف کاذب و کف کاذب (هر دو). طراحیاش آیندهنگرانه و توسعهپذیر است. زیرساختش را با دقت تغییرپذیر ساختهاند. همچنین برای اینکه مصرف برق بهینه شود، بار مصرفی را کموزیاد میکنند.

در این گفتوگو مهندس ارشد تاسیسات توضیح میدهد که چگونه eBay چنین مرکزدادهٔ پرتجهیزاتی را ساخته است. آنهم با نصف هزینهٔ سرمایهای، با نصف هزینهٔ عملیاتی، با نصف زمانی که معمولا صرف این کار میشود؛ ولی با ظرفیت چهار برابر.

آشنایی با مرکزدادهٔ «پروژهٔ مرکوری» شرکت eBay

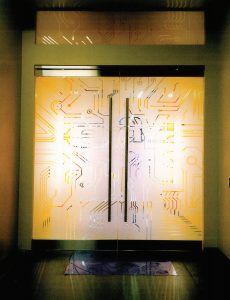

تصویر: مرکزداده «پروژهٔ مرکوری» شرکت eBay در شهر فینیکس در آریزونا

فروشگاه بزرگ و آنلاین eBay در سال ۲۰۱۱، مرکزداده «پروژهٔ مرکوری» خود را با جلوهٔ ظاهری فیلم علمی تخیلی «ترون: میراث» در شهر آریزونا در مرکز ایالت فینیکس ساخت.

بر روی درهای این مرکزداده طرح مدارهای کامپیوتری نقش بسته است، دیوارها با نورپردازی موضعی تزئین شدهاند، همچنین پنلهایی بهرنگ آبیِ یخی در انتهای هر ردیف از سرورها با فونت خاص فیلم ترون: میراث شمارهگذاری شدهاند. شرکت eBay در افتتاحیهٔ باشکوه پروژهٔ مرکوری، ویدئویی ده دقیقهای پخش کرد که در آن کارمندان با لباسهای شبیه ترون، دیسکهای دادهٔ درخشان و شمشیرهای لیزری نورانی بهدست، مانند فیلم، آمادهٔ نبرد برای جلوگیری از «حملهٔ محرومسازی از سرویس» (DoS) ـ[2] بودند.

شرکت eBay علاوه بر بهکاربردن سبک خطوط نئونی فیلم ترون، به شعار تبلیغاتی این فیلم یعنی «بازی عوض شده» نیز توجه کرده است. برای مثال بهجای اینکه از طراحی کارشناسان خودش استفاده کند یا فروشندگان پروژههای قبلی را به کار بگیرد، مناقصهای عمومی برای پروژه برگزار کرد و از شرکتها دعوت نمود تا طرحهای خود را برای ساختن این مرکزداده پیشنهاد بدهند. همچنین این شرکت روش مشابهی دربارهٔ تولیدکنندگان کانتینر و سختافزار در پیش گرفت و بدین ترتیب کار خود را با چنین شیوههایی بهینهتر کرد: استانداردسازیِ پیکربندی سختافزارها، اولویتبندی برنامههای کاربردی، تعریفکردن فرایندهایی برای استقرار رکها و کانتینرهای پر شده از رک برای اینکه امکان نصب سرور جدید بنا به تقاضا فراهم شود.

در زیرساخت فیزیکی این مرکزداده چیزهای بسیار جدیدی وجود دارد. از جمله سرمایش با آب گرم، استفاده از رک و کانتینر هر دو، سرمایش با دو روشِ مبتنی بر هوا و مبتنی بر آب، همچنین کف کاذبی چنان عمیق که موتور سیکلتهای نورانی ترون زیر آن میتوانند با هم مسابقه بدهند!

دین نلسون (Dean Nelson) مدیر ارشد خدمات بنیادی بینالمللیِ eBay، در این مصاحبه دربارهٔ زنجیرهٔ تامین و طراحی مرکزدادهٔ این شرکت میگوید. اینکه چگونه چنان بهینهسازی شده است که کارآمد باشد و با بهرهوری مطلوب کار کند و بهسرعت گسترش یابد.

مشخصات تاسیسات:

- نام سازمان: eBay

- مکان: آمریکا، ایالت آریزونا، شهر فینیکس

- شروعبهکار: اکتبر ۲۰۱۱

- ویژگیهای چشمگیر: یک سالن سرور در داخل ساختمان و یک مرکزدادهٔ کانتینری بر روی بام، استفاده از هر دو نوع سیستم سرمایش با هوا و سرمایش با مایع، استفاده از سرمایش طبیعی، امکان تنظیم سرعت پردازش

- مدت زمان طراحی و ساخت: ۲۲ ماه

- مساحت: ۳٬۹۰۰ متر مربع شامل ۱٬۳۰۰ متر مربع برای نگهداری سرورها در درون ساختمان و فضای قرارگیری کانتینرها بر روی بام

- برق: مقدار اولیه ۴ مگاوات برای فاوا، قابلیت افزایش تا ۶ مگاوات برای سالن سرور داخلی و ۶ مگاوات برای کانتینرها

- رتبهبندی: کلاس دو (Tier 2)

- تعداد رکها: ۲۵۶ رک در سالن سرور اصلی، ۱۰ تا ۱۲ کانتینر روی بام. تعداد رکهای درون هر کانتینر بسته به پیکربندی متفاوت است.

- ظرفیت برق: ۱۴ تا ۲۸ کیلووات در هر رک

- زیرساختها: کابلهای الکتریکی و کابلکشی ساختیافته و سرمایش از سقف، لولهکشی سرمایش آبی از زیر کف کاذب با عمق ۱٫۸ متر

- بار سازهای: ۳٬۶۶۲ کیلوگرم در هر متر مربع

- سیستم اطفای حریق: سیستم دو مرحلهای پیشعملگر، سیستم تشخیص سریع دود VESDA ـ[3]

متن مصاحبه

الگر: eBay مشخصات کارش را تعیین کرد و از شرکتهایی که مرکزداده میسازند خواست طرحهای پیشنهادی خود را به مناقصه بیاورند. بدین ترتیب ساختن مرکزدادهٔ پروژهٔ مرکوری بهروشی ویژه انجام شد. درباره ساخت این مرکز برای ما توضیح بدهید.

نلسون: من در سال ۲۰۰۹ به شرکت eBay پیوستم. وقتی بود که آنها مرکزدادهٔ پروژه توپاز (Project Topaz) را میساختند که مرکزدادهای است کلاس چهار در شهر «سالت لیک سیتی» (Salt Lake City) در ایالت یوتا. اواسط پروژه بود که من مسئولیت آن را به عهده گرفتم و تا اردیبهشت ۲۰۱۰ آن را کامل کردم.

دستاندرکاران ساخت پروژهٔ توپاز نوآوریهای زیادی در این مرکزدادهٔ کلاس چهار به کار بردند. در این مرکز در طراحی بهرهوریِ مصرف برق (PUE)، با افزایشدادن کمینه دمای قابل قبول در سالن سرور موفق شدند به عدد ۱٫۴ دست یابند. همچنین روشهای زیادی را برای رسیدن به بهترین بهرهوری با موفقیت آزمودند و دستآخر به سطح ولتاژ ۴۰۰ رسیدند. در پروژهٔ توپاز کارهای چشمگیر زیادی در این صنعت کردند که بهرهگرفتن از آنها نیازهای ما را برآورده میکند؛ با این حال مشکل این بود که رویکردهای قدیمیِ بسیاری نیز در کارشان وجود داشت.

در طرح این مرکز، سه اتاق ۱٬۸۶۰ متر مربعی وجود داشت که تعداد UPS بهازای هر اتاق ثابت بود. فضای زیادی پیشبینی کرده بودند تا بتوان همهٔ تجهیزات را در آن جا داد. کار با این نگرش پیش رفته بود که مسئلهٔ جا کمهزینه است. یعنی باید ساختمان را طبق برنامه بهطور کامل میساختند؛ سپس تجهیزات را بهتدریج و بهاندازهٔ توسعهٔ نیاز مهیا میکردند. دراینباره تصمیمهای زیادی گرفتند که در آنها بیشتر به تاسیسات توجه شده بود. من به این نکته توجه میکردم که مرکزداده در سطح کلاس چهار است. اما تا آنوقت هیچکس از برنامههای کاربردی، فهرست دارایی تهیه نکرده بود تا بدانیم برای مرکزدادهٔ کلاس چهار چه چیزهایی لازم است و برای مرکزدادهٔ کلاس پائینتر چه چیزهایی. بدین ترتیب من برای اولین گام، به مراحل عقبتر برگشتم و کار را ارزیابی کردم. با این ارزیابی فهمیدیم ۷۰ تا ۸۰ درصد از برنامههایی که در مرکزدادهٔ ما اجرا میشوند و تجهیزاتی که از آنها بهره میگیریم تا آن برنامهها در مرکزداده کار کنند، مناسب برای مرکزدادهٔ با کلاس دو هستند. اینجا بود که تصمیم گرفتیم در برنامهها تجدیدنظر کنیم. این اولین اصل کاری ما بود.

اکنون من در سازمانی کار میکنم که همه مسئولیتها و هزینهٔ مراکزدادهاش را مستقیم بر عهده میگیرد و برونسپاری نمیکند. بنابراین همهٔ مراکزداده و شبکهها و زنجیرهٔ تامین و امنیت و دیگر چیزها در اختیار خود من است. یکی از مدیران که همارز من است، آمادهسازی را بر عهده دارد. او تجهیزات انبارهایِ خدمات زیرساختی ایجاد میکند تا تجهیزات را در هرجا که لازم باشد و برای هر برنامهای راهاندازی کنیم و به کار بگیریم. بدین ترتیب تجهیزات مهیا میشوند. پس از این مرحله میتوان تصمیمگیری کرد و تجهیزات را گسترش داد. همتای دیگر من کسی است که عملیات سایت و کارهای تحلیلی را انجام میدهد. او پیوسته بر سلامت و زمان فعالیت سایت و نیز همهٔ دادههای مربوط به آن نظارت میکند و همه اطلاعات مربوط به وضعیت را ارائه میکند.

چیزی که ما فهمیدیم این بود که باید این برنامهها را بهاصطلاح دستچین کرد تا بتوان تشخیص دارد از کدامیک باید در مرکزداده استفاده بشود. مشکل این بود که واقعا نمیدانستیم چهچیزی را لازم داریم یا چه وقتی آن را لازم داریم. بنابراین میبایست رویکردی جامع و ماژولار پدید میآوردیم. من معتقدم که رویکرد ماژولار در این کار واقعا اهمیت دارد. بهکاربردن رویکرد ماژولار در تمامی ساختار، این امکان را فراهم میکند که تجهیزات را هرجا لازم باشد گسترش بدهیم و نیز کمک میکند بتوانیم مرکزدادهای داشته باشیم که همزمان کلاسهای متعددی دارد (Multi-Tier). در این حال از آنجایی که ما مرکزدادهٔ کلاس چهار نیز داشتیم، چگونه میتوانستیم ظرفیت را با داشتن مرکزدادهای با چند کلاسه در کنار آن افزایش بدهیم؟ با خودمان گفتیم نباید سرمایهگذاریهایی را که تاکنون کردهایم هدر برود. پس بیایید سر دربیاوریم که چگونه میتوانیم مرکزدادهٔ کلاس چهار بسازیم و آن را طوری بهینه کنیم که برای آینده دستمان را باز بگذارد. در این کار برای آزاد کردنِ امکانات مرکزدادهٔ کلاس چهار، ابتدا تجهیزات را از آن بیرون بردیم و منتقل کردیم به مراکزدادهٔ کلاس دو که در کنار آن بود. در این مراکزدادهٔ کلاس دو، تیم پشتیبانی و زیرساخت برق و امنیت و کانالهای زیرساختی با مرکزدادهٔ کلاس چهار همانند بود و همگی در یک سایت قرار داشتند.

پس از این کار به چیزهایی پرداختیم که میخواستیم در مرکزداده قرار بدهیم. SKUها [4] و پیکربندیهای بسیار زیادی وجود داشت. افراد زیادی بودند که انتخاب میکردند چهنوع سختافزارهایی در مرکزداده به کار برود؛ اما بهدرستی استانداردسازی نمیکردند. در اوایلِ همین سال ما دراینباره فکر کردیم که چگونه میتوانیم از تعداد SKUها بکاهیم و آنها را استاندارد کنیم. برای این کار ۱۵ عدد از برترین SKUها را انتخاب کردیم و توانستیم آنها را به دو بسته تبدیل کنیم: یکی برای بستهٔ نرمافزاری Hadoop که بهمقدار زیادی سختافزارِ ذخیرهسازی نیاز داشت، یکی هم برای اقلام سختافزاری. ما از پردازنده و حافظه و شبکهٔ متعارف استفاده کردیم. بعد فکر کردیم که شاید حالا بتوان همهنوع برنامهای را در این استخر مجازی رایانشی اجرا کرد؛ حتی موتور جستجو.

سپس همین را روی زنجیرهٔ تامین اجرا کردیم و سرانجام فهمیدیم که هدف چه باید باشد. بسیار خوب! حالا که SKUهای استاندارد داشتیم، چطوری باید آنها را مونتاژ میکردیم؟ این کار را به شرکتهای تولیدکننده سپردیم تا برای ما چیزی را بسازند که به آن Rack & Roll ـ[5] میگویند. روش کار اینطوری است که ما مشخصات و پیکربندی آنچه را که میخواهیم به شرکت تولیدکننده میدهیم؛ آنها تجهیزات لازم را فراهم میکنند، میسازند، رکها را آماده میکنند، کابلکشی میکنند، نرمافزار نصب میکنند، تست میکنند، کنترل کیفیت میکنند، برای ما میفرستند. هنگام استفاده، ما فقط چنین رکی را به برق و شبکه وصل میکنیم. این همان Rack & Roll است.

تصویر: اولین چیزی که بازدیدکنندهها هنگام ورود به مرکزداده eBay مشاهده میکنند، خوشآمدگویی با تم فیلم ترون است.

وقتی به موضوع دقت میکنید میبینید بهدستآوردن بهرهوریِ خوب، با کارآمدتر شدن فرایند زنجیرهٔ تامین و بهینهشدن تعداد SKUها (با تهیه سختافزارهای یکسان) ممکن شده است. افزون بر آن بهمناقصهگذاشتن پروژهها هم بود که افراد زیادی در آن شرکت کردند و قیمتگذاریهای بسیار خوبی هم داشتیم. پس میتوان گفت که اصل دیگرِ من در این کار چنین بود: ادغام SKUها.

در مرحلهٔ بعدی به محاسبات مربوط به مقدار برق مصرفی برای عملیات میزانِ بار کاری پرداختیم. دو مقداری که میخواستیم به آنها دست یابیم، ۱۴ کیلووات و ۲۸ کیلووات بود. ما رک 48U داریم که حدود ۱٬۶۰۰ کیلوگرم وزن دارد. در یک پیکربندی ۹۶ سرور داریم که در رک واحدی جا گرفتهاند. از منظر شبکه اکنون در موقعیت بیخطر هستیم. ما پریزهای برق و سیستم سرمایش بهینهشده داریم. تمامی این اجزا کنار هم میآیند تا SKU را با آن مشخصاتی داشته باشیم که میخواستیم. حالا میتوانیم آن را به تولیدکننده سفارش بدهیم. آن رک ۲۸ کیلوواتی که گفتم واقعا مناسب است. بهطوری که میتوان در حجم کمتر، ظرفیت رایانشیِ بیشتری داشت و در نتیجه تعداد رکهایی را که باید با آنها کار بشود کاهش داد. ما در تاسیسات اشتراک مکانی، اجاره را برحسب ظرفیت مصرف برق سرورها میپرداختیم. با این وضع به نظر میرسید با ظرفیت کمتر، هزینه کمتری نیز خواهیم پرداخت. اما برای اینکه ظرفیت بدون کمشدن از توان پردازش کاهش یابد، باید رکهای بیشتری به کار بگیرید و در واقع هزینهٔ بیشتری صرف کنید.

با این توضیح بعد از سنجش هزینهٔ کلی، به این نتیجه رسیدیم که برای اینجا باید ۹۶ سرور در هر رک و ۲۸ کیلووات را در نظر بگیریم، یا ۴۸ سرور برای SKU دوم که همان SKU مربوط به Hadoop باشد. سپس شروع کردیم به استفادهٔ جدی از آن. تاسیسات را بهگونهای طراحی میکردیم که بتواند از پس هر مقدار از بار بربیاید. ولی در واقع چنین بوده که هر رک باید امکان افزایش را تا حداکثر ۲۸ کیلووات میداشت. آنگاه به آنچه که داشتیم در فینیکس میساختیم نگاه کردیم. اکنون چگونه میتوان حداکثر ظرفیت را در مرکزداده فراهم کرد، در حالی که همزمان هم از نظر زیرساخت توسعه مییابد و هم فناوری آن بهروز میشود و تجهیزات به داخل و خارج جابهجا میشود؟

همهچیز داشت کمکم هماهنگی مطلوب را به دست میآورد. آنوقت با خودمان گفتیم «میخواهیم مرکزدادهٔ ما در آریزونا باشد که سرمایش طبیعی داشته باشد». تحقق بخشیدن به این هدف در آریزونا برای ما بسیار دشوار بود. برای این کار مناقصهٔ عمومی برگزار کردیم تا فعالان این صنعت بیایند و شرایطی را که میخواستیم ممکن کنند. شرایط ما اینها بود: بهرهگرفتن از سرمایش طبیعی در تمام فصول سال، بهرهگرفتن از راهکارهای «مرکزدادهٔ چند کلاسه»، بهرهگرفتن از راهکارهای ماژولار، تغییرپذیری. گفتیم که میخواهیم روی بام ساختمان رک یا حتی کانتینر داشته باشیم؛ پس این بخش را در فضای کوچکی ساختیم. وقتی میخواستیم ساختن بنا را شروع کنیم، این ایده مطرح شد که چرا آن را در زمین خودمان در کنار مرکزدادهٔ فعلی نسازیم؟ اینجا بود که بحث رک ۱٬۶۰۰ کیلوگرمی و کانتینرها و دیگر موارد پیش آمد. ما در ساختمان به ۴۵۳٫۵ تن فولاد نیاز داشتیم. در واقع ما ساختمان سه طبقه را با کیفیت ساختمانی ده طبقه میساختیم. ولی وقتی همهٔ این عوامل را در کنار هم قرار دادیم، از نظر هزینه راه مطلوبی برای ساختن مرکزدادهٔ چند کلاسه پیدا کردیم. چون در کنار همین مرکزداده مرکزدادهٔ دیگری با کلاس چهار داشتیم.

برگذار کردن مناقصهٔ عمومی برای حلکردن دشواریِ ساخت این مرکزداده واقعا کار بجایی بود. eBay در مناقصه دربارهٔ روش ساخت مرکزداده هیچچیز نگفت، فقط گفت که «این مشکلات ما است، اینها هم چیزهایی هستند که باید طراحی بکنید. حالا شما بگویید که چطوری چنین مرکزدادهای را میسازید». این روش واقعا نتیجه داشت و خیلی هم خوب کار کرد. مهندسان مشاور و طراحان در شرکتهای معماری و شرکتهای مهندسی، واقعا به این شرایط کار کردن علاقه دارند. نوآوریهای بسیار خوبی ارائه شد و این افراد واقعا خلاقیت به خرج دادند.

بهکار گرفتن چنین فرایندی بسیاری از محدودیتهایی را که مهندسان در گذشته و در پروژههای دیگر با آنها روبهرو بودند از سر راه برداشت و آنها توانستند همهٔ فکرشان را بر روی حل مشکلات پروژه متمرکز کنند.

سرانجام ما «شرکت EDI» ـ[6] را برندهٔ مناقصه انتخاب کردیم و آنها نیز شرکتهای «مهندسان مشاور AHA» ـ[7] و «معماران Winterstreet» ـ[8] را وارد کار کردند. هر سه شرکت به طراحیای واقعا تغییرپذیر و ساده و کارآمد و ماژولار دست یافتند. وقتی آن را به ما نشان دادند، ما گفتیم «بسیار خوب! حالا باید کمی هم آن را بزرگتر بکنید؛ چون درخواستهای ما دو برابر شده است. فضایی هم که باید روی آن کار کنید کمی بیشتر از قبل است. حالا با این وضعیت بگویید بیشترین میزان تجهیزاتی که میتوانید در این فضا جا بدهید چقدر است؟ چه چیزهایی را میتوان در آن جا داد؟ ظرفیت مطلوب چقدر است؟ دیگر اینکه میخواهیم بهتدریج آن را در بخشهای ۲ مگاواتی افزایش بدهیم.»

تصویر: در انتهای هر ردیف، پانلهای روشن بر جلوهٔ مدرن و آیندهنگرانهٔ مرکزدادهٔ eBay میافزاید.

چیزی که سرانجام در فضای ۱٬۳۰۰ متر مربعی به آن دست یافتیم، امکان افزایش ظرفیت فاوا از ۴ به ۱۲ مگاوات بود. اگر این ظرفیت را میان فضایی با مساحت ۱٬۳۰۰ متر مربع توزیع کنیم، نیمی از آن برای کانتینرهای روی بام و نیم دیگر برای Rack & Rollهای طبقهٔ سالن است و در نهایت هر رک ۲۸ کیلووات دارد. این جالب است که چطور همهٔ عوامل دستبهدست هم دادند و باعث شدند بتوانیم با همین فضایی که داریم، چنین میزانی از ظرفیت به دست آوریم. امروزه فناوری این امکان را فراهم کرده که کانتینرها را روی بام بگذاریم. ما نقطهٔ هدف را ۴۵۰ کیلووات قرار دادیم؛ زیرا این معادل با حداکثر میزان جریان هوایی است که میتوان برای سرمایش دائمی رکهای ۲۸ کیلوواتی در آن فضای بستهٔ کانتینری به گردش درآورد. بدین ترتیب با گذاشتن رکها بر روی بام، ما از سقفی از هوا بهرهمند شدیم! خیلی عالی است!

علاوه بر این ما میخواستیم مرکزداده در تمام سال از سرمایش طبیعی استفاده کند. به همین دلیل «دمای مرطوب» [9] مرکزداده را در گرمترین روز سال اندازهگیری کردیم که ۲۹٫۴ درجه سانتیگراد شد. «چرخهٔ آب گرم برگشتی» را بر همین اساس طراحی کردیم. دمای این چرخهٔ آب گرم ۳۰ درجه سانتیگراد است؛ چون این همان دمایی است که آب برگشتی از پنل سرورها به آن میرسد. ما همچنان میخواهیم از همین دمای ۳۰ درجهٔ سانتیگراد که تجهیزات امروزی را با هوا خنک میکنیم، در سرمایش تجهیزات آینده نیز بهره بگیریم. من دلم میخواست برای خودِ CPUها هم سرمایش با مایع داشته باشم؛ دمای ۳۰ درجه برای خنککردن CPU عالی است.

میبینید که تا اینجای کار کمکم همهچیز داشت کنار هم قرار میگرفت و هماهنگ میشد. ما در کار ساختن مرکزدادهٔ بسیار تغییرپذیر بودیم که امکان میداد سطح کلاس و ظرفیت را همگام با نیازهای کسبوکار تغییر بدهیم. نیازهای کسبوکار همیشه تغییر میکنند؛ اما برای ما بهمعنای واقعی کلمه یکشبه تغییر کردند. وقتی به این مرکزداده نگاه میکنیم، میبینیم که بهخوبی دست خودمان را باز گذاشتهایم. ما امروزه از بهترین شیوههای سرمایش با هوا استفاده میکنیم. داریم فضای سالنها و زنجیرهٔ تامین و بهرهوری را به بیشترین حد ممکن میرسانیم.

برای بعضی از کانتینرهایی که داریم در مرکزداده جا میدهیم، دمای ۳۱ درجه را برای دالان سرد در نظر میگیریم. بقیه از هوای آزاد و سرمایش تبخیریِ معمولی بهره میگیرند و در بیشتر سال سرمایش طبیعی دارند. ما در رکها به بهرهوری مصرف برق با رقم کمتر از ۱٫۱ در ظرفیت ۲۸ کیلووات رسیدهایم. نتیجهای که میتوان گرفت این است که هزینهٔ کلی بهازای هر مگاوات کاهش مییابد. چون همهٔ عوامل گرد آمدهاند تا چیزی ساخته بشود که مناسب کسبوکار باشد. نه اینکه اول چیزی را بسازیم که مرکزداده نیاز دارد؛ بعد تازه به فکر هماهنگکردن تجهیزات با کسبوکار بیفتیم.

این درس خیلی مهمی برای ما بود. ما راهبرد چند کلاسهٔ ماژولار را به وجود آوردیم که امکان داد مرکزداده را گسترش بدهیم. اما متن RFP را بر اساس واقعیتهای تجهیزات رایانشیِ موجود بازار تنظیم کردیم. بدین ترتیب که اعلام کردیم ۹۶ سرور برای این دو SKU میخواهیم؛ یعنی ۴۸ سرور در هر رک. نوع پیکربندیها را نیز برای CPU و حافظه و شبکه روشن کردیم. همهٔ مشخصات را به شرکتکنندگان دادیم. آنگاه گفتیم بر اساس هزینههای واحدی که در پروژه مصرف میکنند به آنها امتیاز میدهیم؛ چون قرار بود بستن رکها و همهکارهای دیگر را خودشان انجام بدهند. همچنین به آنها به مقدار مصرف برق طرحِ پیشنهادی، بهازای میانگین حجم کار مرکزداده در طی عمر مفیدش نیز امتیاز دادیم. بدین ترتیب ما هزینهٔ استهلاک سرور را بعلاوه مجموع هزینهٔ برقی که تجهیزات در سه سال عمر مفید خود مصرف میکنند در نظر گرفتیم؛ چون این هزینه را ما پرداخت میکنیم. برای تجهیزات فاوا و انتخاب تولیدکننده بر همین اساس یعنی بهای تمامشدهٔ واقعی تصمیم گرفتیم. از این بابت بسیار خشنود بودم. نتیجهٔ این کار خیلی خوب شد. برندهٔ اولین دور مناقصه تولیدکنندهای بود که تعجب و حیرت همه را با طراحی پربازدهاش برانگیخت. سپس ما به شرکتکنندگانی که بازنده شده بودند اعلام کردیم که چهچیزی باعث شده است در مناقصه ببازند. آنها هم رفتند در طرح خود تجهیزات را اصلاح و تنظیم کردند که در نتیجه در دور دوم تولیدکنندهٔ دیگری برنده شد.

دو محصول مختلف برای تجهیزات روی بام و دو تولیدکنندهٔ دیگر را نیز برای تجهیزات سالن انتخاب کردیم. اکنون این دو فضا افتتاح شدهاند و هر دو هم بسیار پربازده هستند و بهرهوری خوبی دارند. بسیار مقرونبهصرفه هستند، ظرفیت زیادی دارند، همچنین هر دو تقریبا در تمام طول سال از سرمایش طبیعی بهره میبرند.

الگر: بیشک خیلیها شهر فینیکس را جای مناسبی برای شیوهٔ سرمایش طبیعی نمیدانند. [10] چطور شد شما این کار را کردید؟

نلسون: من خودم از بخش فاوا آمدهام و خیلی از تولیدکنندهها را دیدهام که نوآوریهای خوب زیادی دربارهٔ تجهیزات فاوا داشتهاند؛ ولی هیچوقت شناخته نشدهاند. چرا؟ چون همه از بودن آب در مرکزداده و از دمای بالا میترسیدند و پیشفرض خود را بر این میگذاشتند که هوا راهحل است.

وقتی در این مشکل دقیق شدم، به این نتیجه رسیدم که دو متغیر در اینجا وجود دارد: دمای سطحی CPU و دمای هوای بیرون. با خودم گفتم آیا میتوان با توجه به این دو متغیر، چیزی طراحی کرد که با آن بتوانیم سرمایش طبیعی داشته باشیم؟ بله!

«خیلی از تولیدکنندهها را دیدهام که نوآوریهای خوب زیادی دربارهٔ تجهیزات فاوا داشتهاند؛ ولی هیچوقت شناخته نشدهاند. چرا؟ چون همه از بودن آب در مرکزداده و از دمای بالا میترسیدند و پیشفرض خود را بر این میگذاشتند که هوا راهحل است.»

وقتی به تولیدکنندگان CPU مثل اینتل و AMD و دیگران نگاه میکنید، میبینید که چون باید محصولاتشان را به همهجای دنیا بفرستند و برای اینکه اطمینان یابند در همهجا دمای عملیاتی درست کار میکند، ناچار ۲۰ یا ۳۰ یا ۴۰ درصد بیشتر از نیاز واقعی سرمایش در نظر گرفتهاند. ولی اگر وضعیت محیط بسیار مناسب باشد، میتوان دما را افزایش داد و در عین حال در چهارچوب محدودیتهای گرمایی تجهیزات پایبند ماند.

با انجام تست Chill Off 3 که آزمایشی برای مقایسهٔ دو محصول سرمایشی در مرکزداده است، ما حجم کار را در سرمایش با هوا و در سرمایش با مایع آزمایش کردیم. با این آزمایش فهمیدیم که با هوای ورودی ۳۱ درجهای هیچگونه افت بازدهی نداریم. متوجه شدیم که با اثر انتقالی گرما مواجه هستیم. بدین ترتیب که هر CPU در موقعیتی است که در جلوی آن یک رم و در پشت آن یک CPU دیگر قرار دارد. در این حالت دمای CPU کنارِ رم افزایش مییابد. این اشکال در سیستم سرمایش با هوا پیش میآید. بهرهوریِ اجرای این شیوه حتی با وجود اثر انتقالی گرما، تنها اندکی کمتر است. ولی همچنان بدون خطا کار میکند و سرورها عملکرد خوبی دارند. سپس کیس سرد (Cold Plate) را تست کردیم که یکی دیگر از موارد آزمایش بود. دیدیم که با وارد کردن مایع به سیستمِ سرمایشی سرورها، اثر انتقالی گرما از رم به CPU که باعث افزایش دمای CPU میشد، از بین میرود و در نتیجه بهرهوری افزایش مییابد. در آن وضعیت میشد از خود پرسید که «آیا با این کار من واقعا دارم CPU را بهینه میکنم؟» چیزی که لازم داشتیم «پدال گاز» بود!

میخواستم این توانایی را داشته باشیم که با کموزیاد کردن فرکانس CPU، سرعت و تولید گرمای آن را تغییر بدهیم. مثل تبدیلکردن ماشین تویوتا به ماشین پرسرعت فراری. وقتی به چنین چیزی نیاز داریم، باید آن را داشته باشیم. اصلا برایم مهم نیست که هزینهٔ برق آن بیشتر بشود. تراشه باید در محدودهٔ دمای مجاز باقی بماند و این با استفاده از مایع برای سرمایش CPU عملی میشود. میتوانیم برای مدیریت بار کاری، از سیستمهای کمتری استفاده کنیم و وقتی حجم کار کمتر است، از تعدد آنها کم کنیم. بدین ترتیب این عامل را هم در نظر گرفتیم.

تصویر: ورودیهای مرکزداده با طرح مدار کامپیوتری تزیین شدهاند.

این نیز در شرایط مناقصه بود که میخواهیم به CPU دسترسی مستقیم داشته باشیم تا بتوانیم ولتاژ را تغییر بدهیم و در نتیجه فرکانس CPU را بر اساس نیاز تنظیم کنیم. ما در آنجا این اهرم کنترلی را داشتیم. در عین حال گفتیم مرکزداده را طوری بسازید که بدون اینکه لازم باشد آن را دوباره و از نو طراحی بکنیم، بتوانیم رک اضافه کنیم. بهطوری که برای سرمایش آن از هوا یا «سرمایش جنبی» (Side Cooling) ـ[11] یا «درب بدون فن» (Passive Door) یا هر راهکار دیگری در اطراف رک استفاده کنیم. یا برای خود CPU از سرمایش مستقیم با مایع بهره بگیریم. به این ترتیب بود که ۲ چرخهٔ آب برای تمام قسمتهای مرکزداده ایجاد کردیم. یک چرخهٔ آب با دمای ۱۳ درجه سانتیگراد و دیگری چرخهٔ آب گرم برگشتی با دمای ۳۱ درجه. بدین ترتیب هم کانتینرها و هم رکها از آن استفاده میکنند. بهطور کلی برای اینکه مقدمات و لوازم این کار از همان ابتدا در طراحی و ساخت فراهم شده باشد، حدود نیم میلیون دلار در شروع ساختِ مرکزداده بیشتر خرج کردهایم؛ برای اینکه استهلاک آن طی ۳۰ سال بسیار ناچیز باشد.

با این کارها توانستیم در فضای مرکزداده از ۵ کیلووات به ۴۰ کیلووات برسیم و به میانگین ۲۸ کیلووات در هر رک دست یابیم. بدین ترتیب عمر مفید مرکزداده بیشتر شد. ما این امکان را به دست آوردیم که همان تجهیزاتی را که امروزه با هوا خنک میشوند، در همان فضای مرکزداده به رکی منتقل کنیم که با مایع خنک میشود و به بازدهیِ بالقوهٔ ۳ یا ۴ برابر حالت قبلی دست یابیم. این محشر است؛ بهویژه که برای آن تنها بهاندازهٔ نصف مبلغ حالت قبل هزینه کردیم.

الگر: جایگزینکردن سرمایشِ هوا با سرمایش مایع چه تفاوتهایی برای شما داشت؟

نلسون: ما برای ظرفیتهای بین ۲۰ تا ۲۵ کیلووات در هر رک هم از سیستم سرمایشِ با مایع استفاده میکنیم. البته هزینهٔ آن با توجه به افزایش توان کمی گرانتر میشود و با ورود محصولات جدید به بازار نیز استفاده از آنها این افزایش هزینه را از توجیه میکند. تولیدکنندگان میدانند بار کاری ما چقدر است و چه هدفی داریم. پس اگر بتوانند به آن تغییرپذیریِ CPU که میخواهیم دست پیدا کنند، از نظر بهای تمامشده برای ما موفقیت بزرگی است. ما نیز تولیدکنندگان را برای رسیدن به این وضعیت ترقیب میکنیم. این ویژگی CPU که به Power Throttling مشهور است، با حالت کممصرف برق (Power Saving Mode) فرق دارد. مزیت بهینهکردن آن چیست؟ باید بتوانید بروید و هروقت نیاز است آن را در حالتی که میخواهید تنظیم بکنید. از نظر من این در مقایسه با آن حالتی که قبلا بود تفاوت بسیاری ایجاد میکند.

اگر درک کاملی از میزان بار کاری در محیط مرکزدادهای که میسازید داشته باشید و بعد شروع کنید بهپیشبردن کار، آنوقت است که میتوانید بگویید با استفاده از سرمایش با مایع، میتوانید این سیستمها را طوری تنظیم کنید که سه سال پیوسته با سرعت بیشتر از حد معمول خود کار بکنند (Overclocking)؛ چون کاملا برای چنین محیطی بهینهسازی شدهاند. آنوقت است که میتوانید پردازندههای ارزانتری بخرید؛ از آنها مثل پردازندههای گرانتر استفاده کنید و همان بازده را به دست بیاورید. در این حالت شاید هزینهٔ واحد تولید یکسان باشد؛ ولی هروقت که خواستیم از آنها استفاده کنیم، تبدیلشان میکنیم به ماشین «فراری». بدین ترتیب ممکن است در ۴ ساعت اوج کاری، هر روز از ۱۲۰ درصد برق معمول استفاده کنیم. اما بعد که مصرف را کاهش دادیم، در ۲۰ ساعت باقیمانده، بار کاریِ کمتر از آن مقدار خواهیم داشت. همچنین در سایر اوقات چون بار پردازشیِ چندانی بر روی کل سامانه قرار ندارد، میتوانیم بخشی از تجهیزات را یا در حالت «در انتظار» نگه داریم یا بهطور موقت غیرفعال کنیم.

ملاحظه میکنید اینجا متغیری داریم که بهاصطلاح مثل «پدال گاز» عمل میکند. لزوما مقدار بار کاری ثابت نیست. وقتی CPU را کنترل میکنید و دمای آن را هم در اختیار دارید، هزینهٔ کلی عملیاتِ این تجهیزات بهمقدار چشمگیری کم میشود. از نظر دما همه بهدنبال این هستند که همین کار را بکنند و میگویند میخواهیم برای سرمایش از هوای آزاد استفاده کنیم. خیلی خوب است؛ اما چیزی که من فهمیدهام این است که خیلیها در طراحی مرکزداده، سالن را پر از تجهیزات و پردازندههای ارزان قیمت میکنند. آنها برای اینکه همان بار کاری را در مرکزدادهٔ کمهزینهٔ خودشان مدیریت کنند و بهرهوری مصرف برق را یکدهم بیشتر کاهش بدهند، در این کار از دو برابرِ تعداد معمول تجهیزات استفاده میکنند. ولی متوجه نکتهٔ اصلی نشدهاند. آنها با خودشان میگویند «اکنون برق مصرفی ما دو سوم قبل شده است»؛ اما توجه نمیکنند که هنوز دارند از دو برابر تعداد معمول تجهیزات استفاده میکنند. در چنین حالتی برق مصرفی آنها بیشتر از مقداری است که ما در مرکزدادهٔ پرظرفیت و با دمای محیطیِ بیشتر استفاده میکنیم.

«خیلیها در طراحی مرکزداده سالن را پر از تجهیزات و پردازندههای ارزان قیمت میکنند. آنها برای اینکه همان بار کاری را در مرکزدادهٔ کمهزینه خودشان مدیریت کنند و بهرهوری مصرف برق را یک دهم بیشتر کاهش بدهند، در این کار از دو برابر تعداد معمول تجهیزات استفاده میکنند. ولی متوجه نکتهٔ اصلی نشدهاند.»

این دیدگاه نسبت به مرکزداده، کلی و جامع است. وقتی واقعا مقدار بار کاریِ مرکزداده را بدانید و زیرساخت تاسیسات را بشناسید، آنگاه آنها را کنار هم قرار بدهید و همانند ماشینی واحد شروع به تنظیم و ایجاد هماهنگی میان آنها بکنید، بهرهوری بسیار خوبی به دست میآورید.

الگر: من متوجه شدهام که سختافزارهای مرکزدادهٔ eBay در بار کاری تنوع چشمگیری دارند. آیا به نظر شما چنین روشهایی در سایر مراکزداده نیز جاافتاده است؟ آیا شیوهٔ شما برای طراحی مرکزداده که آن را بهاصطلاح «امکان تغییر قابلیتهای CPU از تویوتا به فراری و برعکس» نامیدید، تنها برای خودتان راهکار خوبی است یا آن را در بیشتر مراکزدادهٔ دیگر هم میتوان به کار برد؟

نلسون: این به جامعبودن رویکرد طراحی مرکزداده برمیگردد. فرض کنید شما کسبوکاری همانند بانک دارید یا فقط سازمان فاوای سنتی هستید. توجه کنید که چنین کسبوکارهایی تجهیزات خودشان را زیاد دگرگون نمیکنند و میتوان گفت تجهیزات با گذشت زمان تقریبا تغییری نمیکند. در این حال اگر از روز اول زیرساخت را ماژولار بسازید، چنانکه قابلیت این را داشته باشد که کمکم آن را گسترش بدهید، دیگر مهم نیست که ۲ سال یکبار آن را توسعه میدهید یا ۷ سال یکبار. نکته این است که به هر حال هر زمان که بخواهید میتوانید ظرفیت مرکزداده را افزایش بدهید؛ چون سرمایهٔ اولیهای که باید برای تهیهٔ لولههای بزرگتر و اتصالات خروجی بیشتر و چنین چیزهایی هزینه بکنید ناچیز است؛ لازم نیست همهٔ تجهیزات پشتیبانی را بخرید. بدین ترتیب من اکنون ۴ مگاوات ظرفیت دارم و اگر بخواهم میتوانم آن را با تقریبا نصف هزینهای که برای تهیه این ۴ مگاوات صرف کردهام به ۶ مگاوات برسانم. بازهم این کار را میکنم و به همین ترتیب ادامه خواهم داد؛ یعنی برای ۲ مگاواتِ اول هزینه میکنم و سپس هزینهٔ ۲ مگاوات بعدی نصف ۴ مگاوات اول درمیآید. با این کار دست خودم را در این مرکزداده باز گذاشتهام و میدانم که در آینده میتوانم ظرفیت را پیدرپی افزایش بدهم.

اینکه ظرفیت مرکزداده چقدر خوب افزایش پیدا میکند، در هرجایی فرق دارد. منظور من جاهای پیشرو است. همان کسانی که در این صنعت تعیینکننده هستند، این شیوه را معمولا در زمینهٔ رایانش پربازده به کار میگیرند. چهکار میکنند؟ اگر به سریعترین کامپیوتر دنیا نگاه کنید میبینید که با مایع خنک میشود. چطور؟ آنجا هم با CPU همان مشکلی را داشتند که همه دارند؛ اما فهمیدند چطور محیط مرکزداده را بهینهسازی کنند. دراینباره ما یک قدم هم جلوتر رفتهایم و فهمیدهایم چگونه محیط را هم برای CPU و هم برای هوای اطراف رک بهینهسازی کنیم و مرکزدادهای بسازیم که هر دو را داشته باشد و بهخوبی هم اداره بشود. حالا اگر این کارها را در همهجا به کار ببرید چه میشود؟ برای اجرای این شیوه مشکلترین مکان سنگاپور است؛ چون بسیار مرطوب است. اگر بتوان در سنگاپور سرمایش مستقیم با مایع را برای CPU به کار برد میتوان از سرمایش طبیعی هم بهرهمند شد.

یعنی در هر مرکزدادهای میتوان این روشها را اجرا کرد و آن را ماژولار ساخت. هزینهٔ اصلی را همان اول صرف کرد؛ سپس بهمرور زمان توسعه داد. البته منظورم توسعه در همهچیز نیست، فقط قابلیت افزودن ظرفیت با اضافهکردن واحدهایی با ظرفیت معین را میگویم. این کار به چگونگی سرمایهگذاری در مرکزداده وابسته است. اگر برای مرکزدادهای فقط ۱۰ سال عمر پیشبینی بکنیم، برای آن باید دستکم ۲ یا ۳ مرحله عملیات بازسازی فناوری در نظر بگیریم. مراکزداده ممکن است در چنین مدتی تا ۵ مرحله عملیات بازسازی فناوری به خود ببیند. ما هر ۲ سال یکبار برای بسیاری از تجهیزات، تعمیرات کلی انجام میدهیم. چون در این مرکزداده از نظر عملکرد و بازده، از محدودیتهای تجهیزات واقعا پیشتر رفتهایم. شما اگر ۵ سال یکبار هم این کار را بکنید، با اجرای این شیوه میتوانید ظرفیت را دو برابر کنید. اگر بتوانید یک رک جدید اضافه بکنید بدون اینکه درگیر نوسازی کل مرکز بشوید و مجبور نباشید با تمام پیچیدگیهای این کار دوباره سر و کله بزنید، به موفقیت بزرگی رسیدهاید. جالب اینجا است که برای بهکاربردن این شیوه، در ابتدای کار دو برابر هزینه نمیکنید؛ بلکه تنها ۱۵ تا ۲۰ درصد بیشتر برای لولهکشی و دیگر زیرساختها خرج میکنید. همهچیز به برنامهریزی درست بستگی دارد.

«وقتی واقعا مقدار بار کاریِ مرکزداده را بدانید و زیرساخت تاسیسات را بشناسید، آنگاه آنها را کنار هم قرار بدهید و همانند ماشینی واحد شروع به تنظیم و ایجاد هماهنگی میان آنها بکنید، بهرهوری بسیار خوبی به دست میآورید.»

الگر: اتفاقا میخواستم بپرسم آیا چرخهٔ سریع بازسازیِ سختافزارهای مرکزدادهٔ eBay را، یعنی تعویض سالانهٔ حدود نیمی از تجهیزات رایانشی، از آغاز در طراحی مرکزداده در نظر گرفته بودید؟ به نظر میرسد شما چنین طراحیای را برای هر شرکتی که چرخهٔ بازسازی سختافزار را چه بهطور مداوم و چه موردی داشته باشد، قابل استفاده میدانید.

نسلون: چرخهٔ بازسازی سختافزار به هر حال انجام میشود؛ فاصلهٔ زمانی بین هر بارِ آن مهم است؛ اینکه این موج سینوسی بلند باشد یا کوتاه.

من در سالنهای فاوا بودهام، در آزمایشگاهها بودهام، در اتاقهای سرور، در مراکزداده و در میان همهٔ آن تجهیزات بودهام. میدانم که نیاز همهٔ آنها یکسان است. دشواری در همهجا این است که تجهیزات رایانشیِ با ظرفیت مشخص دارند که باید آنها را در جایی بگذارند و برق و سرمایش آنها را تامین کنند. چرا برای همهٔ این کارها، تغییرپذیرترین و انعطافپذیرترین زیرساخت را نمیسازید؟

آنها که سرمایش مرکزداده را فقط با هوا میسازند، در آینده گرفتار میشوند. آیا شیوهٔ سرمایش با هوا خوب کار میکند؟ حتما! اما آیا با فناوریهای جدیدی که بهتازگی وارد این عرصه میشوند هم سازگار هست؟ با همهٔ آنها نخیر! ما به فروشندگان فشار میآوریم تا راهکارهای سرمایش با مایع را به میدان بیاورند. ما میدانیم به چه شیوهای در این مرکزداده نیاز داریم؛ بنابراین محصولاتی میخواهیم که برای همان شیوه کاملا مناسب باشند. مرکزدادهٔ ما نشانهٔ برجستهای از فناوریهایی است که به میدان خواهند آمد و به اعتقاد من صنعت مرکزداده میتواند از این نشانه استفاده کند. اگر آنها چنین فناوریای را وارد مرکزدادهٔ خود بکنند و از آن بهره بگیرند، حتما خواهند توانست همین حجم کاری را با نیمی از تجهیزات کنونی خود یا حتی کمتر از آن مدیریت کنند. هر فعالی در صنعت فاوا اگر از راهکار سرمایش با مایع برای CPUها استفاده کند، خواهد توانست مرکزداده را با تنها نیمی از سرمایهٔ معمول توسعه بدهد. در مرکزدادهای که نتوان در آن از این شیوه استفاده کرد، برای افزودن این قابلیت باید بیشتر از آنچه که میارزد خرج بشود.

سالها این را گفتهام که موضوع مهم، توازن و اتحاد سازمانی است. من معتقدم رمز موفقیت eBay دقیقا همان همکاری گروه تاسیسات و گروه فاوا با همدیگر است. یعنی اینکه همهٔ ما در آن سهیم هستیم و در آن نقش داریم؛ همهٔ ما در یک کار مشترک هستیم و اهداف و بودجه ما یکی است. همه ما باید هزینه را بهازای هر مگاوات کاهش بدهیم تا ظرفیت واقعی را که شرکت بدان نیاز دارد فراهم کنیم. این یعنی وات بهازای هر تراکنش آنلاین، وات بهازای هر کاربر، وات بهازای هر متغیر دیگری. وات بهازای هر متغیری که باشد، به هر حال وات همان وات است و فرقی ندارد. هرچه از وات مصرفی بکاهیم و از تمام امکاناتی که هست بهره بگیریم، از افزایش بهرهوری سرورها گرفته تا بهرهوری مرکزداده، سرمایش با مایع، سرمایش با هوا، هر چیز دیگری؛ در واقع وات مصرفی را برای همهٔ متغیرها کاهش دادهایم.

الگر: زیرساخت مرکزداده را چگونه اجرا کردهاید؟ از زیر کف کاذب؟

نلسون: بله و کمی هم این کار متناقض به نظر میرسد. من کف کاذب دوست نداشتم چون بهنظرم نوعی اتلاف است. برای رساندن سرمایش به رکها حتما که لازم نیست کف کاذب داشته باشیم. سرمایش ماژولار طوری است که میتوانیم بهراحتی از واحدهای تهویهٔ مطبوع جنبی استفاده کنیم یا سرمایش را از بالا برای رکها تامین کنیم. با این حال چیزی که فهمیدم این بود که برای این محیط، کف کاذب سودمند است و بدین ترتیب آن را با عمق ۱٫۸ متر ساختیم.

تصویر: لولهکشی سرمایش با مایع، در زیر کف کاذب با عمق ۱٫۸ متر انجام شده است. برق و سرمایش با هوا و کابلکشی از راه سقف توزیع شده است.

میدانم این متناقض است که من کفی کاذبی درست کردهام که از جمله عمیقترین کف کاذبهای مراکزداده است؛ در حالی که خودم اصلا خوشم نمیآمد. اما توجه کنید که ما از آن فقط برای لولهکشی آب استفاده کردهایم نه انتقال هوای سرد. آن ۲ چرخهٔ آب گرم بازگشتی را از زیر همین کف کاذب به همهٔ رکها متصل کردیم. الان میتوانیم از واحدهای تهویهٔ مطبوع جنبی استفاده کنیم، یا درب عقب بدون فن کار بگذاریم. یا وقتی آن رکهای مجهز به سرمایش با مایع به بازار آمدند، سرمایش را مستقیم به هریک از رکها برسانیم.

من بسیار تاکید دارم که در دور بعدیِ بازسازی فناوریِ این مرکزداده، از تجهیزات سرمایش با مایع استفاده کنیم. به نظر من این تجهیزات زودتر از آنچه دیگران گمان میکنند در اینجا نصب خواهند شد و آنگاه که در اینجا شروعبهکار بکنند و نشان بدهند که از این بهاصطلاح پدال گاز چه استفادههایی میشود کرد، همهچیز برای مردم روشن میشود. دیگران به اینجا نگاه میکنند و با خودشان میگویند «من زیرساخت مرکزدادهام را با در نظر گرفتن توان بازسازیِ بعد از سانحه ساختهام که از نیمی از امکانات آن استفاده میشود و نیم دیگرش هم بیکار مانده است. الان هم با اینکه فقط از نصف ظرفیت سرورها استفاده میکنم، باز برای زیادبودن مصرف برق جریمه میدهم.» درعوض حالا تصور کنید که در مرکزداده، فقط نیمی از آن مقداری که معمولا لازم هست تجهیزات داشته باشید؛ طوری که هرموقع نیاز داشتید بتوانید از ۱۳۰ درصد از توان آنها استفاده کنید. میبینید که هروقت بخواهید میتوانید از پدال گاز استفاده کنید. اوج مصرف ما فقط ۴ ساعت در روز است و در بقیهٔ روز توان پردازش را کم میکنیم.

چیزی که ما میخواهیم به دست بیاوریم افزایش ظرفیت است؛ هم عمودی هم افقی. ۱۰۰ عدد از رکهای ما مشغول کارِ جستجو برای پیدا کردن موجودی کالا است. اگر در زمان اوج کار به تمام آن ۱۰۰ رک نیاز داشته باشیم و آنها را واداریم که با سرعت بیشتر از حد معمول کار بکنند، احتمالا ۷۰ عدد از آنها برای کار جستجوی ما کافی خواهند بود. پس «افزایش ظرفیت عمودی» یعنی اینکه ۷۰ رک داشته باشیم و چنان از آنها کار بکشیم که توان پردازشی آنها برابر با ۱۰۰ رک باشد.

البته با پایان زمان اوج کار هم نمیتوانیم توان پردازشی CPUها را خیلی کم کنیم؛ چون عملکرد جستجوی eBay طوری است که نتیجهٔ درخواست جستجوی محصول باید با تاخیر کم به کاربر ارائه شود. برای همین «آستانهٔ توان پردازشی» تعیین میکنیم؛ طوری که از ۲ گیگاهرتز کمتر نشود. بدین ترتیب کارکرد همهٔ آنها را در غیر زمان اوج کار، تا ۲ گیگاهرتز کاهش میدهیم. سامانه با این میزان از توان پردازشی، عملکرد مناسب را خواهد داشت. اگر هم فقط به ۳۰ عدد از رکها نیاز باشد، میتوان بقیهٔ رکها را بهحالت انتظار خدمت (Hibernate) درآورد. هرگاه هم که ببینم دارد نیاز به ظرفیت کم میشود، رکهای در حالت انتظار را فعال میکنیم. این کار «افزایش ظرفیت افقی» است.

منظور من این است که زیرساخت را طوری میسازیم که هرگاه لازم بود بتوانیم ظرفیت رکها را هم افقی و هم عمودی کموزیاد کنیم. ما از بار کاری فاوا شناخت داریم و بین آن و زیرساخت، هماهنگی و ارتباط ایجاد میکنیم تا موتورمان با بهرهوری مطلوب و موثر کار کند. فرض کنید مرکزداده ماشین است. کسانی که بدنهٔ ماشین را طراحی میکنند نمیدانند موتور داخل آن چگونه کار میکند. کسانی هم که موتور را طراحی میکنند، توجه یا نگرانیای نسبت به سرمایش و چیزهای دیگر ندارند. در نتیجه بین گروههای فنی شکاف به وجود میآید. در این مثال از کل ماشین منظور مرکزداده است، از موتور منظور فاوا است، از پدال گاز و همهٔ چیزهای مرتبط با آن منظور سیستم کنترل مرکزداده است. حالا اگر کل ماشین را یک گروه طراحی کند، این گروه در هنگام طراحی بین همهٔ این جنبهها هماهنگی برقرار میکند. این چیزی است که میخواهیم به دست بیاوریم: ماشینی که تمام اجزای آن هماهنگ با همدیگر کار میکند.

ما همچنین بهدنبال ایجاد همگرایی و یکپارچگی در زیرساخت هستیم. در مرکزدادهٔ Salt Lake City گمانم بر بیش از ۲۴۰ هزار نقطه نظارت و پایش میکنیم. برای این کار از «سامانهٔ PI» ـ(PI System) ـ[12] استفاده میکنیم. سامانهٔ PI سیستمی است که از آن در نیروگاههای هستهای هم استفاده میشود. این سیستم دقت مدیریتی کافی را برای کار با میلیونها میلیون نقطه و حسگر دارد. کاربرد آن هم این است که میخواهیم دادهها را از این سیستم بگیریم و به مرکزداده بدهیم تا خودش تشخیص بدهد. مثلا اینکه: «الان در فینیکس شب است. چون شبها هوا خنکتر است میتوان از همهٔ سیستمهای اینجا با سرعت بیش از حد معمول کار کشید و حجم کار را به آنجا فرستاد. پس میتوان از این CPUها کارکرد بیشتری دریافت کرد؛ زیرا دمای هوا ۲۱ درجهٔ سانتی گراد است در حالی که در گرمای روز دما ۳۰ درجه است. تمام موتور هماهنگ شده و حالا برنامهها میتوانند از آن استفاده کنند. همهٔ تجهیزات اکنون با هم مرتبط و متصل هستند.» هدف نهایی ما همین است؛ اینکه بتوانیم ماشینی داشته باشیم که خوب هماهنگ و تنظیم شده باشد و تنها آن مقداری که نیاز دارد برق مصرف کند. در عین حال بتواند بر اساس تقاضای کسبوکار عملکرد و بازدهی داشته باشد.

الگر: معمولا در مصاحبههایی که برای این کتاب میکنم میپرسم که چه اصولی را در طراحی مرکزداده توصیه میکنید. شما تا اینجا ماژولار بودن، مقیاسپذیر بودن، داشتن رویکرد جامع و همهجانبه نسبت به مرکزداده، همچنین منتظرِ آمدن فناوری سرمایشِ با مایع بودن را توصیه کردید. توصیهای دیگری هم دارید؟

نلسون: بله. رویکرد چند کلاسه (Multi-Tier). با ایجاد زیرساخت ماژولار باید بتوانید هر کلاسی را که میخواهید به دست بیاورید. وقتی مرکزداده را کلاس چهار میسازید، فقط مرکزدادهٔ کلاس چهار دارید. اما اگر تاسیساتی بسازید که امکان توسعه و ارتقا به کلاس چهار را داشته باشد، یا بخشی از آن کلاس چهار و سایر قسمتها بین کلاس یک تا سه باشد، به خودتان امکان تغییرپذیری بسیار بیشتری دادهاید. دستکم نیم یا بخش کمتری از تجهیزاتِ بیشتر شرکتها، واقعا به زیرساخت کلاس چهار نیاز دارد.

حتی در صنعت بانکداری نیز تراکنشها و همهٔ اطلاعات در مرکزداده ذخیره میشود؛ زیرساخت شبکه باید کلاس چهار باشد. موتور رایانشیای که این کارها را انجام میدهد ممکن است در مکانیهای مختلفی باشد؛ درست مثل جستجوگر eBay. باید بتوانید آن را در مکانهای گوناگونی که کلاس پایینتر دارند هم قرار بدهید. بدین ترتیب توصیهٔ دیگر من تعیین نیازها و اندازهٔ صحیح برای برنامهها است.

یک توصیهٔ دیگر من همان چیزی است که پیشتر اشاره کردهام. اینکه باید مطمئن بشوید تیم فاوا و تاسیسات میتوانند با هم کار کنند؛ به طراحی رویکرد متحدی دارند و با هم بهدنبال رفع مشکل هستند.

الگر: چند سال پیش در پروژهٔ مرکزدادهای شرکت داشتم که میخواستند فضاهایی با چند کلاس بسازند. نظر مخالف با این کار این بود که وقتی چنین مقداری خرج میکنید، برای اینکه زیرساخت بنیادیِ مرکزدادهٔ کلاس چهار داشته باشد، باید کل مرکزداده را کلاس چهار بسازید. اگر این کار را نکنید در حقیقت برای بخشهایی که افزونگیِ کمتری در طراحیشان نیاز دارند، بیشتر از اندازه هزینه کردهاید. شما چگونه این مشکل را حل میکنید؟ شاید هم بهنظرتان هزینهای که میگویند زیادی است، نسبت به طول عمر مرکزداده به چشم نمیآید؟

نلسون: ما ۲۸۷ میلیون دلار برای مرکزدادهٔ کلاس چهار eBay در شهر Salt Lake City هزینه کردیم. عجب پروژهای! مستحکم، عظیم، باوقار. دقیقا همان مرکزی است که نیاز داریم. اکنون درست در کنار این مرکزداده داریم مرکزدادهٔ دیگری میسازیم که ظرفیتش حدود ۴ برابر آن یکی است؛ اما برایش تنها نیمی یا شاید هم یکچهارم آن یکی هزینه میکنیم. میتوانم ادعا کنم که در طول عمر این یکی، مرکزدادهٔ دیگری خواهم ساخت با چهار برابر ظرفیت آن، با نصف هزینه.

«فرض کنید مرکزداده ماشین است. کسانی که بدنهٔ ماشین را طراحی میکنند نمیدانند موتور داخل آن چگونه کار میکند. کسانی هم که موتور را طراحی میکنند توجه یا نگرانیای نسبت به سرمایش و چیزهای دیگر ندارند. در نتیجه بین گروههای فنی شکاف به وجود میآید.»

در مرکزدادهٔ Salt Lake City ظرفیت معینی داریم. چون اگر امروز که داریم فضا را با تجهیزات پر میکنیم، تاسیساتی نمیساختیم که تجهیزات کلاس پائینتر را آنجا بگذاریم، همهٔ برق برای تجهیزات رایانشی کماهمیتتر صرف میشد. به این ترتیب برای سرمایهگذاری اولیهٔ کلاس چهار، کاری که احتمالا لازم است انجام بدهید این است که ببینید چه مقداری از مرکزداده را باید با استانداردهای کلاس چهار بسازید. تعجب میکنم که بیشتر از ۵۰ درصد مرکزداده را کلاس چهار میسازند. من با ساختن ۵۰ درصد از مرکزداده با کلاس چهار و ۵۰ درصد دیگر با کلاس دو، ۲ تا ۳ برابر ظرفیت کلاس دو را در اختیار دارم و دستم را برای اِعمال برنامه و مدیریت منابع باز میگذارم؛ یعنی چهار برابر مقداری که در کلاس چهار میتوانم داشته باشم. اگر مرکزداده را ماژولار بسازیم، هر زمان که بخواهیم میتوانیم ظرفیت عملیاتی آن را افزایش بدهیم. ما میخواهیم ۷۵ تا ۸۰ درصد تجهیزات از مرکزدادهٔ کلاس چهار خارج بشود. این مقدار قابل توجهی است.

تصویر: نورپردازی موضعی در داخل مرکزداده eBay

با این آزادی عمل، به خودم ۵ تا ۱۰ سال دیگر زمان دادهام. چون تازه از بخش اعظم بار کاری که مرکزدادهٔ کلاس چهار داشت راحت شدهام و کلی ظرفیت خالیِ قابل استفاده دارم. بدین ترتیب فقط شبکهٔ مرکزی و ذخیرهسازهای اصلی و پایگاههای دادهٔ مهم و چیزهای دیگری را که بههیچوجه نباید از کار بیفتند در آن میگذارم. توسعهٔ این دسته از سیستمها خیلی کندتر از سایر تجهیزات انجام میشود. از چیزهایی که میتوان توسعه داد، سرورهای جستجو هستند یعنی سرورهای سامانهای که کاربر با آنها سروکار دارد. اینها همانهایی هستند که میخواهیم هر ۲ سال یکبار تعویض کنیم؛ چون کل بار کاری در آنجا قرار دارد. آنها اطلاعات را از سامانهٔ پایگاه داده فراخوانی میکنند و طبعا از شبکه استفاده میکنند. البته این سرورهای لایهٔ کاربری، مقدار زیادی هم برق مصرف میکنند.

دربارهٔ مراکزدادهٔ چندکاربره، اگر کوچکترین واحد آن را رک فرض کنیم، وقتی که رک را در مرکزداده قرار میدهیم، فارغ از اینکه به چهچیزی اختصاص داده میشود مثلا بنگاه تجاری یا نرمافزار خاص، اگر زیرساخت عمومی کابلکشی و برق و غیره بهگونهای باشد که امکان تخصیص منابع را مهیا کند، دیگر برایمان فرقی نمیکند بهرهبردار چهکسی باشد. ما برای اینکه محیط امنی داشته باشیم، میتوانیم درِ هر رک را قفل کنیم یا آنها را در هریک از بخشهای مختلف حفاظتشده قرار بدهیم. ولی هنوز این مسئله وجود دارد که باید بتوان هر چیزی را در هرجایی با هر ظرفیت و فاصلهای قرار داد و هر سرویسی را به هریک از بهرهبردارها که نیاز دارند رساند.

این قضیه مستلزم این است که تیم شبکه بهخوبی بفهمد کجا باید مرزبندی کند و چطور باید مناطق بحرانی را برای بازیابیِ پس از سوانح، تفکیک و ایزوله کند. باید خوب دربارهٔ این مسائل فکر کنند. اکنون ما محیطی تغییرپذیر را در اختیار آنها قرار دادهایم. امروزه در بسیاری از مراکزداده وضعیت به این شکل است که برای اضافهکردن ظرفیت، آدم باید سر دربیاورد که کدام سرور خشابی و در کدام شاسی، برق کافی و اتصالات مطلوب شبکه خواهد داشت. این اشتباه است. باید اینطوری باشد که بگوییم «چه ظرفیت پردازشی را لازم دارید؟» در آنصورت اگر بتوانیم آن را تامین و در مرکزداده میزبانی کنیم، معلوم میشود که مدیریت یکپارچهای داشتهایم. چنین چالاکی و سرعتی برای ما بسیار بسیار مهم است.

داشتن قابلیت تغییرپذیری در هر شرکت و هر ادارهٔ فاوا کارها را آسان میکند. به این صورت که وقتی مدیریتِ آن را به دست گرفتید، کافی است مراحل تعدیل را شروع کنید و بازسازی فنی را انجام بدهید. همهٔ این عملیات پرمخاطره را وقتی با جسارت کامل میتوانید انجام بدهید که زیرساخت تغییرپذیر و منعطف داشته باشید. زیرساختی که به شما امکان بدهد تجهیزات آنها را در مرکزداده جا بدهید. شاید کسبوکار پررونقِ مبتنی بر اینترنت مانند eBay یا آمازون یا گوگل نداشته باشید. اما مطمئنا در مرکزداده رویکردی مشابه آنها نسبت به ماژولار بودن و ایجاد تغییرپذیری دارید؛ برای برخوردار بودن از رشد منظم و همچنین برای اجرای کاملا مقرونبهصرفهٔ این کارها، هم از نظر سرمایه و هم از نظر بهرهوری عملیاتی.

الگر: در طول این پروژه مسائل غافلگیرکننده هم پیش آمد؟

نلسون: بله البته. یک چیزی پیش آمد که خیلی برایم جالب بود. ما تلاش میکردیم که بتوانیم سرورها را تنها با یک کابل ورودی به برق متصل کنیم. اگر ازکارافتادن سرورها بهعلت قطع برق محتمل بود، آنوقت زیرساخت را میبایست پایدارتر طراحی میکردیم. اما ما سیستمی را میخواستیم با یک ورودی برق که امکان تعمیر و نگهداریِ بدون نیاز به ازکارانداختن داشته باشد. این کار ممکن به نظر نمیآید؛ اینکه هر سیستم فقط یک کابل ورودیِ برق به سرور داشته باشد و قابل تعمیر و نگهداریِ بدون ازکارانداختن نیز باشد. گفتیم «بسیار خوب، ما سیستم تکورودی برق داریم. حالا بیایید سوئیچهای انتقال خودکار (ATS) و چیزهای دیگر را هم نصب کنیم. بدین ترتیب سیستمهای تککابلی داریم که بدون ازکارافتادن میتوانیم تعمیر و نگهداریِ زیرساخت را انجام بدهیم. ولی در این حال بازهم ریسک زیادی وجود دارد؛ چون در حین تعمیر و نگهداری و کارهای دیگر ممکن است تجهیزات از کار بیفتند. به همین دلیل بیایید برای زیرساخت اصلی، تغییرپذیری بیشتری بسازیم.» اما وقتی به عقب نگاه کردیم و دربارهٔ همه تلاشهایی که کرده بودیم فکر کردیم، متوجه شدیم که با این کار حدود چندصد هزار دلار در منابع تامین برق و واحدهای توزیع آن صرفهجویی کردهایم. با این حال دیدیم برای عملیکردن این کار در حقیقت داریم میلیونها دلار برای زیرساختِ سوئیچهای انتقال خودکار (ATS) و مقدار بسیار زیادِ برق و باقی چیزها هزینه میکنیم.

تصویر: درهای کشویی در انتهای دالانهای ۷ و ۸ (چپ باز، راست بسته)

ما روش کار را واقعا درست در میانهٔ راه تغییر دادیم و گفتیم که سوئیچ انتقال خودکار (ATS) پیچیده است؛ نمیشود مطمئن بود در مقیاس ۴ مگاواتی کار میکند یا نه. یعنی این کاری بود بسیار بسیار عظیم که میخواستیم آن را عملی کنیم تا بتوانیم عملیات تعمیر و نگهداری را بدون ازکارافتادن سرورها انجام بدهیم.

از انجام این کار که منصرف شدیم گفتیم: «بسیار خوب، ما میخواهیم دو کابل به هر سرور وصل شود. یکی از مسیری که مجهز به UPS و ژنراتور است و دیگری به برق شهر که فقط تعدیل شده است. پس در این حالت هم میتوانیم تعمیر و نگهداری منبع تغذیهٔ اول را انجام بدهیم.» با این روش هم دقیقا همان وضعیتی را که در ابتدا دنبالش بودیم به دست میآوردیم. هزینه را حدود ۳ میلیون دلار کاهش دادیم که در نهایت ۲٫۵ میلیون دلار صرفهجویی خالص داشتیم؛ چون به هر حال هنوز باید برای کابل برق و منابع تغذیهٔ برق و تجهیزات توزیع بار هزینه میکردیم.

این برای ما از آن لحظاتی بود که آدم ناگهان متوجه چیزی میشود و میگوید: «آهان، همینه!» تلاش کردیم مشکل را با ایجاد تغییرپذیرترین زیرساختی حل کنیم که میتوانستیم بسازیم. واقعا باید نگاه کنید که چهچیزی میخواهید؛ سپس آن را با سادهترین شکل انجام بدهید. این هم از ماجرای تجهیزات فاوا با دو کابل ورودی برق.

من از این حالتِ دو کابل ورودی برق برای همهچیز استفاده میکنم. هیچگاه سراغ سیستم تکورودی برق نمیروم. گرچه خیلیها هم هستند که سیستم تکورودی را به کار میبرند؛ برای CPUهای کممصرف و سختافزارهای ارزانِ با فرکانس پائین. با این کار بیشک با قطعی مواجه خواهند شد. وقتی تجهیزاتی دارید که در آنها احتمال قطعی برق وجود دارد، به هر حال هم اتفاق میافتد. وقتی میشود کاری کرد که با قطعی مواجه نشویم، چرا خودمان را گرفتار کنیم؟

در واقع ما داریم یک منبع برق دیگر هم اضافه میکنیم. با این کار از منابع تامین برق اضطراری و ژنراتور اضافی که هزینهٔ زیادی دارند، دیگر استفاده نمیکنیم. بنابراین هنوز هم از همهٔ مزایای اصلیِ این شیوه بهرهمند هستیم. خلاصهاش این است که در مرکزداده برای هریک از سیستمها، دو منبع برق داریم و در کنار آن برای تجهیزاتی مثل زیرساخت شبکه که داخل ساختمان قرار دارند و واقعا لازم است که زمان فعالیت بیشتری داشته باشند، از منابع برق اضطراریِ اضافی استفاده کردهایم. این بخش از زیرساخت، کلاس سه تلقی میشود؛ با آنکه زیرساخت بالادستیاش کلاس چهار است. اما من واقعا نمیخواهم این سیستمها با قطعی روبهرو شوند. این بخش از مرکزداده فقط ۳ درصد بار و فضا را در بر میگیرد. در سایر بخشهای مرکز از سیستمهای دو کابلِ ورودی برق استفاده شده است که یک کابل به مسیرِ تغذیهٔ مجهز به ژنراتور و UPS متصل است و دیگری به برق شهری. اینها درس بسیار خوبی بود که ما در این پروژه آموختهایم.

الگر: چیزهای دیگری هم بود که یاد گرفتهاید؟

نلسون: گذاشتن کانتینرها روی بام خیلی خوب است؛ اما اگر مجبور نیستید این کار را نکنید. من ترجیح میدهم بهجای اینکه کانتینرها را روی بام قرار بدهم، ساختمانی دو برابر وسیعتر داشته باشم که بتوانم همه کانتینرها را کف زمین بگذارم. فضای مرکزدادهٔ ما محدود به همین مقداری بود که داشتیم. در این ساختمان از ۴۵۳٫۵ تن فولادِ بیشتر استفاده کردیم تا ساختمان بتواند وزن تجهیزات را تحمل کند. با این حال وزن کانتینرهایی که وارد مرکز شدند دو برابر مقدار مشخص شده بود؛ بنابراین برابر وزنِ ۴۴٫۵ تن را بردیم بالا و روی بام گذاشتیم. اکنون ۱٬۹۲۰ سرور در آنجا داریم که تعداد زیادی است. برای انتقال آنها به بام از جرثقیلی ۹۱ تنی استفاده کردیم.

تصویر: نیمی از ظرفیت مرکزدادهٔ eBay با کانتینرهای روی بام تامین میشود.

از وقتی کانتینرها را تحویل گرفتیم، درست ۲۲ دقیقه طول کشید که از کامیون به بام منتقل شدند و کار وصلکردن برق و داده و سرمایش را آغاز کردیم. با این حال عملیکردنِ آن کار انرژ زیادی برد. دربارهٔ سایر کانتینرها هم از آنجایی که میخواستیم موقعیت، اندازه، ابعاد، وزن یا هر چیز دیگرِ مربوط به آنها تغییرپذیر باشد، مجبور شدیم یک مجموعهٔ پست توزیع برقِ ثانویه روی بام بسازیم تا بتوانیم آنها را هماهنگ کنیم یا هرطور که شد جانمایی کنیم. ما تغییرپذیری میخواستیم. به هر حال هنوز داریم از کانتینرهای همین دو تولیدکننده استفاده میکنیم؛ اما فردا ممکن است تولیدکنندهٔ دیگری با کانتینر بهتر از راه برسد و ما بخواهیم از آن هم استفاده بکنیم. میخواستیم در آینده قابلیت انجام چنین کاری را داشته باشیم و بتوانیم از کانتینر جدید نیز در این محیط استفاده کنیم. استفاده از سکوی بتنی یا فضایی که امکان بدهد جابهجایی بهآسانی و بدون نیاز به جرثقیلهای بزرگ انجام بگیرد، میتواند صرفهجویی بسیار زیادی به همراه بیاورد.

چیز دیگری که یاد گرفتیم این است که اگر ضرورت ندارد همهچیز را بهسرعت بسازید، این کار را نکنید؛ اگر میتوانید به خودتان زمان بیشتری بدهید. تیم ما واقعا خوب بود؛ چون در توافق بر سر قطعات اصلی که نیاز داشتیم مجبور نشد کیفیت را فدا کند. با این حال طبق لیستها، محدودیتهایی برای تولیدکنندگانی که میتوانستند با ما همکاری کنند وجود داشت. ما نتوانستیم از واحدهای ترکیبیِ ژنراتور و UPS تنظیمشده استفاده کنیم. به این دلیل که نتوانستیم آنها را قبل از تنگشدن مسیرهای عبوری تهیه کنیم؛ اندازه آنها زیادی بزرگ بود. این مسئله باعث شد بعضی از تولیدکنندگان نتوانند در این پروژه حضور داشته باشند. بعد مجبور شدیم کوتاه بیاییم و ژنراتورها و UPSها را جداگانه تهیه کنیم. الان نتیجهٔ کار قابل قبول است؛ ولی واقعا ترجیح میدهیم از آن واحدهای ماژولاری داشته باشیم که قابلیت ذاتی یکپارچهسازی دارند. چون وقتی با هم جفت میشوند، کارکرد بهتری پیدا میکنند. مسئول یکپارچهسازی این واحدها همان تولیدکنندهٔ معتبر است. اکنون این ماشینی است کاملا تنظیم شده که از تعامل محصولات دو تولیدکنندهٔ مستقل تشکیل شده است و کلیهٔ تنظیمات هماهنگسازی آنها در باس و سوئیچیگ بهدقت نظارت میشود.

تصویر: هریک از کانتینرها با بیش از ۱٬۵۰۰سرور پر شده و سپس با جرثقیل به پشتبام منتقل شدهاند.

نکتهٔ دیگر درباره ضریب توان AC است. تعداد کمی از شرکتها محصولی تولید میکنند که قابلیت تغییر این ضریب را در مقیاس بار مگاواتی داشته باشد. اگر UPS بتواند ضریب توان را با توجه به بار مصرفی اصلاح کند، ژنراتورها با هیچ مشکلی مواجه نخواهند شد. اگر ضریب توان برق AC در تجهیزات سرور خیلی بالا باشد، ژنراتورهای شما را از کار میاندازد. شرکتهای پیشرو مانند مایکروسافت و گوگل و شرکت خودمان را در نظر بگیرید. وقتی این کانتینرهای ۱٬۰۰۰ تا ۲٬۰۰۰ سروری را روی بام میگذارید، واقعا باید آن نکته را هم جدی بگیرید. بدین ترتیب لازم است چیزی میان مسیر برق قرار بدهید که آن را اصلاح یا فیلتر کند و بتوانید در چهارچوب اصلاح ضریب توان AC باشید. البته این اصولا بهدلیل شیوهٔ طراحی است؛ ما UPS تبدیل دوگانه نداریم که از شر بار راحت بشویم.

الگر: نام «پروژهٔ مرکوری» [13] را از کجا گرفتهاید؟

نلسون: هرچه به خورشید نزدیکتر بشویم گرمتر میشود. اسمش را پروژهٔ مرکوری گذاشتیم چون ما هم داریم به منبع گرما نزدیکتر میشویم. برای مرکزدادهٔ ماژولارِ بعدیمان هم نام «پروژه کوئیکسیلور» [14] را انتخاب کردهایم. چون از ویژگیهای جیوه حرکت و تغییر سریع آن است و این دقیقا همان قابلیتی است که ما در این مرکزداده میخواهیم داشته باشیم؛ باید بتوانیم خود را بهسرعت تطبیق بدهیم. دیگر اینکه جیوه مایع است و ما هم در نهایت با شیوهٔ سرمایش مستقیم CPU با مایع روی آوردهایم.

الگر: گفتید مرکزداده ۱٬۳۰۰ متر مربع سالن سرور دارد. در آن چقدر فضای بیشتر برای سیستمهای الکتریکی و مکانیکی استفاده کردید؟

نلسون: تقریبا دو برابر فضای سالن. چون ما از واحدهای بزرگتری استفاده کردیم و ژنراتورهای ۳ مگاواتی به کار بردیم. بههمین دلیل داریم هر بار یک بخشِ ۳ مگاواتی اضافه میکنیم. UPSهای کنونی ۲ مگاواتی هستند. از نظر اندازههای آنها، نوعی عدم مطابقت پیش آمد. با این حال الان میدانیم که بخش بعدی را میتوانیم هر زمان که نیاز داشته باشیم اضافه کنیم؛ برای اینکه ژنراتورها هنوز افزونگی N+1 دارند. پس فکر میکنم فضای تجهیزات الکتریکی و مکانیکی ۲ برابر فضای سالن باشد.

شیوهٔ معماری فنی ما این بود که چون باید برای بعضی تجهیزات آب سرد تامین شود، یک چرخهٔ آب ۱۳ درجهٔ سانتیگرادی را اجرا کردیم و بعد یک چرخه دیگر ۳۱ درجهای. بنابراین اینجا چرخهٔ کندانسور داریم. هر ۲ چرخه مستقیم به تجهیزات متصل هستند و میتوانیم هروقت که بخواهیم انتخاب کنیم کدامیک را به کار بگیریم. با این توضیح اگر ۱۲ مگاوات ظرفیت با افزونگی N+l داشته باشیم، آنوقت میتوان گفت که ۸ مگاواتِ آن واقعا کندانس خواهد بود. اگر مشخص بشود که میتوان از بعضی از چیلرها بهرهوری بیشتری به دست آورد، میتوان آنها را هم گسترش داد یا میتوان تعداد چیلرها را افزایش داد یا بهرهوری را با کاهش فشار کار و افزایش تعداد کندانسورها بیشتر کرد. قرار نیست همهچیز با آن چرخهٔ ۳۱ درجهای تناسب داشته باشد، بنابراین نمیتوانیم الان برایش حکم قطعی صادر کنیم. پس هنوز تغییرپذیری عامل تعیینکنندهای است.

اگر همهجانبه آن را در نظر بگیریم، کمتر از ۵ درصد از کل هزینهٔ سرمایهای را صرف این قسمت کردیم تا بتوانیم آن تغییرپذیری را که میخواستیم به دست بیاوریم. دراینباره هم طراحی ما از همان ابتدا تغییرپذیر بوده است و همهٔ مهندسان مشکل را میدانستهاند. ما با آنها وقت زیادی را گذراندیم تا چالش کسبوکار و اعداد نهایی را برایشان توضیح بدهیم. در نهایت مقدار ظرفیت در هر رک را که نیاز داشتیم، برحسب فضای سالن و برحسب ظرفیت موجود کلِ سیستمهای تاسیساتی مشخص نمودیم و هدفمان را تعیین کردیم که آنها را کمکم توسعه خواهیم داد.

ما میدانستیم که در بعضی قسمتهای سالن سرور باید تجهیزاتِ کمتر از ۱۰ کیلووات قرار بدهیم؛ ولی در بعضی قسمتهای دیگر هم Rack & Rollها را داریم با ۲۵ یا ۲۸ کیلووات. فکر کردیم که میتوانیم از پس هر دوی آنها بربیاییم و بعد با گذشت زمان واحدهای ماژولار اضافه کنیم و آنها را گسترش بدهیم. اکنون همین طور که ظرفیت مرکزداده بیشتر میشود، به واحدهای ماژولار در سالن میافزاییم. این تجهیزات جاگیر هستند؛ اما وقتی آنها را با تجهیزاتی که از سرمایش با مایع استفاده میکنند جایگزین کنیم، بازده زیاد میشود و مثل این است که تمام آن فضا را دوباره به دست آورده باشیم. بنابراین میتوانیم در ۷۰ درصد از فضای سالن سرور، رکهای ۴۰ کیلوواتی بگذاریم. این کار نتیجهٔ خوبی دارد؛ این یعنی چند صد رک که تعداد خیلی زیادی است.

الگر: با آنهمه فولادی که مجبور شدید در این سازه استفاده کنید، اکنون ساختمان این مرکزداده چه وزنی را تحمل میکند؟

نلسون: ساختمان ۵۷ تا ۶۴ تن وزن کانتینرها را با همهٔ اجزای پشتیبانش تحمل میکند؛ یعنی میتوانیم ۱۰ الی ۱۲ کانتینر روی بام بگذاریم.

یکی از محصولاتی که استفاده کردیم ۴۴٫۵ تن وزن دارد و دیگری ۵۰٫۸ تن. نمیدانیم تجهیزاتی که در آینده از تولیدکنندگان دیگر در مرکزداده تحویل خواهیم گرفت، اگر سرمایش با مایع داشته باشند سبکتر خواهند بود یا سنگینتر؛ چون سرمایش با مایع باعث میشود تجهیزات سنگینتر باشند. اما در عوض زیرساخت کمتری لازم خواهند داشت. اگر از مایع استفاده کنیم دیگر به سیستمهای انتقال هوا نیازی نخواهیم داشت. ما زیرساخت مایع برای CPUها خواهیم داشت؛ آنهم مایع با جریان کم. بدین ترتیب این مقدار همانند مقدار مایعی است که به کانتینرها وارد میشود. ولی اکنون این مایع بهجای اینکه لازم باشد بین هواسازها توزیع بشود، بهطور مستقیم بین تجهیزات توزیع میشود. محصول دیگری هم هست که کاملا از هوای بیرون و کولر تبخیری بهره میگیرد. این محصول تنها مقدارِ کمی آب شهری مصرف میکند.

من از این قضیه خیلی خوشحالم؛ چون مرکزداده از راهکار سرمایش ۱۰۰ درصدیِ با هوای بیرون استفاده میکند. درست در کنار آن طراحیای وجود دارد که از مبدل برودتی استفاده میکند و منبع اصلی آن برپایهٔ چرخهٔ آب ۳۱ درجهای است. اگر هر زمانی بهدلیل هر مسئلهای دما از ۳۱ درجه بیشتر بشود، با چرخهٔ آب ۱۳ درجهای تبادل گرما میکند تا باز به دمای ۳۱ درجه برگردد. بدین ترتیب همهچیز در هماهنگی کامل و تحت کنترل است.

این راه بسیار ارزان و مبتکرانه بود تا بتوانیم از سرمایش مستقیم با آب گرم، در کانتینر برای تجهیزات مبتنی بر سرمایش با هوا استفاده کنیم. من واقعا به آن افتخار میکنم. تولیدکنندگان طبق خواستهٔ ما دربارهٔ رفع این مشکل بهخوبی فکر کردند. نتیجهٔ آن ایجاد دو راهکار کاملا منحصربهفرد و متفاوت شد که هر دو در این مرکزداده اعمال شدهاند؛ کاری که از آن بهرهوریِ PUE با میانگین سالیانهٔ ۱٫۱ به دست آمد. واقعا عالی است!

تصویر: پریزهای برق نورانی در کانتینر تاریک

هرکسی ایدهٔ بهتری پیشنهاد کند، ما میخواهیم آن را در مرکزداده اجرا کنیم. همچنین اجازه میدهیم رقابت ادامه پیدا کند؛ چون فروشندگان رقابت را دوست دارند. شرکتهای HP و Dell و Oracles و IBM را در نظر بگیرید؛ همه دارند برای کسبوکار رقابت میکنند. با این حال چیزی که واقعا به آن نیاز دارند کسبوکار فاوا است. آنها درک میکنند که ما داریم میان فاوا و زیرساخت هماهنگی ایجاد میکنیم. این شرکتها برای بهرهوری و کارآمدیِ کلیشان است که برنده میشوند. این واقعا خوب است.

مسئلهٔ دیگر دربارهٔ کانتینرها است. در حال حاضر ۴ یا ۵ نسل از کانتینرها را پشت سر گذاشتهایم. اکنون هر تولیدکنندهای تلاش میکند وارد بازار شود. ولی تجهیزاتی را که در داخل کانتینر هست باید کسی ضمانت کند و الان بهترین شخص برای این کار همان تولیدکنندهٔ حقیقی است. یک واحد کامل مانند رکی بسیار بزرگ است و در واقع، کانتینری است با زیرساخت برق سر خود و سرمایش و اتصال به شبکه. آن را یک واحد در نظر میگیرند و استاندارد UL ـ[15] نیز آن را بهشکل واحد ضمانت میکند. ما فهمیدهایم که این مناسبترین راه برای استقرار و نصب چنین تجهیزاتی است. بسیار هم مقرونبهصرفه است. من ۵ تا ۱۰ میلیون دلار تجهیزات در این کانتینرها دارم. میتوان کانتینر ارزانتری ساخت. ولی اگر این کانتینر برای تجهیزاتی که داخل آن است تنظیمشده و مناسب نباشد، دچار خطا میشود. خطایی که تجهیزات چند میلیون دلاری ما را با خطر آسیبدیدگی مواجه میکند. هرگز نباید چنین اتفاقی بیفتد.

بهنظرم ابعاد در صنعت کانتینرسازی کمکم کوچک میشود. البته این الان فقط پیشبینی است. کانتینر همانند رک بزرگ است. افرادی که آن را میسازند در واقع آن را برای ارسال و حملونقل میسازند. خیلی چیز خوبی است. ما در یک روز در رکهای کانتینری ۱٬۹۲۰ سرور نصب کردیم و هفتهٔ بعد هم ۱٬۵۰۰ تای دیگر آوردیم. همهٔ آنها را در ۲۲ دقیقه نصب کردیم. تعدادی دیگر هم هفتهٔ بعد از آن وارد مرکز کردیم و کنار تجهیزات دیگر گذاشتیم. به این ترتیب تقریبا ۴٬۰۰۰ سرور را در کمتر از ۱۲ ساعت نصب کردیم. این خیرهکننده است!

«هرکسی بهترین ایده را پیشنهاد کند ما میخواهیم آن را در مرکزداده اجرا کنیم.»

در تاریخچهٔ این شرکت پیش نیامده بود که اینهمه تجهیزات را به یک مرکزداده eBay بیاوریم. نکته هم همین است؛ ما چنین کاری را با نصف هزینهٔ عملیاتی و نصف هزینهٔ سرمایهای انجام میدهیم و با نصف زمانی که معمولا صرف این کار میشود و البته با ظرفیت چهار برابر. این خیلی جالب است. همین است که من عاشق کارم هستم؛ چون فرصت میدهد چنین کارهایی را انجام بدهم.

پانویس

[1] این مطلب ترجمهٔ بخش نهم از کتاب «The Art of the Data Center» است. گفتوگوکننده داگلاس الگر (Douglas Alger)، مترجم پرواز خیّر، ویراستار پرهام غدیریپور، بهکوشش دکتر بابک نیکفام، تهیهشده در باشگاه مراکزداده

[2] Denial of Service attack (DoS)

[3] Very Early Smoke Detection Apparatus

[4] Stock-Keeping Unit (بهاختصار SKU): برای اشاره به محصولی خاص استفاده میشود و در واقع کد شناسایی هر محصول در کاتالوگ یا فروشگاه است. SKU ویژگیهایی همچون نام تولیدکننده و اندازه و رنگ و نوع بستهبندی را در بردارد. این کد تنها برای محصولات فیزیکی به کار نمیرود؛ بلکه از آن برای چیزهای فروختنیِ غیرفیزیکی، همچون خدمات و وارانتی و مجوز نیز بهره میگیرند.

[5] Rack and Roll که صدایش همانند Rock and Roll نام موسیقی محبوب قرن بیستم است، در اینجا بهمعنی رکهای بستهبندیشده و آمادهبهکار است؛ چنانکه که در زمان استفاده نیاز به هیچ پیکربندیای ندارد.

[6] شرکت EDI: فعال در زمینهٔ مشاوره و طراحی فاوا. در آتلانتای جورجیا و دنور کلرادو دفتر دارد.

[7] شرکت AHA Consulting Engineers: متخصص در زمینهٔ طراحی مکانیکی و برق و لوله کشی. در آتلانتای جورجیا و بوستون و واشنگتن دی سی دفتر دارد.

[8] Winter Street Architects

[9] دمای مرطوب (Wet-bulb Temperature): نشاندهندهٔ توان تبخیری رطوبت از هوا است. این دما معمولا با دماسنجی جیوهای اندازهگیری میشود که آن را با دستمال مرطوب پوشاندهاند. دمای هوای مرطوب بستگی به رطوبت نسبی هوا و دمای خشک و ارتفاع از سطح دریا و فشار هوا دارد و معمولا کوچکتر مساوی با دمای خشک است.

[10] فینیکس از گرمترین مناطق آمریکا است که در ۱۱۰ روز گرمِ سال، از اواسط خرداد تا پایان تابستان، میانگین دمای آن ۳۸ درجه سانتیگراد یا بیشتر است.

[11] سرمایش جنبی: به سیستم آرایش رک و تجهیزات سرمایشی میگویند که در کنار رک و به موازات آن قرار دارد.

[12] Plant Information System: زیرساخت نرمافزاریِ مدیریت آنی و دائمیِ داده در نیروگاههای تولیدی.

[13] پروژه مرکوری (Project Mercury): نام اولین برنامهٔ ناسا برای فرستادن انسان به مدار زمین است. از دستاوردهای این پروژه، فرستادن اولین آمریکایی به مدار زمین بود که سومین نفر در جهان به شمار میآید. مرکوری بهمعنای عطارد است.

[14] کوئیک سیلور (Quicksilver) بهمعنای جیوه است.

[15] Underwriters Laboratoreis: سازمانی است در شیکاگو، با تخصص مشاوره و تصدیق ایمنی. این سازمان ۶۴ لابراتور دارد و یکی از چندین شرکت تایید شده برای انجام آزمون ایمنی در آمریکا است. UL به عرضهٔ خدمات تصدیق، تایید، تست، وارسی، ممیزی، مشاوره، همچنین آموزش در ارتباط با ایمنی میپردازد. مشتریان بسیار گوناگونی دارد که تولیدکنندگان و خردهفروشان و سیاستگذاران و شرکتهای خدماتی و مصرفکنندگان را شامل میشود. این سازمان دارای استانداردهای زیادی در زمینههای سازگاری با محیط زیست، محصولات برقی و الکترونیکی، ایمنی، تجهیزات کتنرل صنعتی، مواد پلاستیکی، همچنین سیم و کابل است.

درج دیدگاه