مرکزدادهٔ ابررایانش بارسلونا (ابررایانهٔ MareNostrum) ـ[1]

آنچه میخوانید

مرکز ابررایانش بارسولنا از مراکز دادهٔ پیشرو است که در واقع ابررایانهٔ دانشگاه فنی کاتالونیا با نام MareNostrum در آن برپا شده است. این مرکزداده را درون کلیسایی قدیمی چنان ساختهاند که از زیباترین مراکزدادهٔ جهان بهشمار میرود. طراحی و ساخت این تاسیسات پیشرفته بهشکلی است که نمای داخلی کلیسای تاریخی هیچ دستکاری نشده و محیط برای بازدید بهخوبی پیدا است. آن را Pecera نامیدهاند که در زبان اسپانیایی بهمعنی «تنگ ماهی» است؛ چون مرکز داده را درون سالن شفاف دربسته ساختهاند.

آشنایی با مرکز ابررایانش بارسلونا

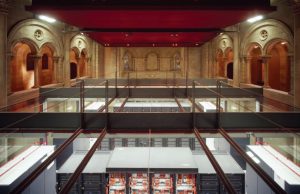

تصویر: مرکز ابررایانش بارسلونا داخل کلیسای کوچک Torre Girona

وقتی مقامات دولت اسپانیا بهدنبال ساختمانی در بارسلونا بودند که بتوانند هرچه زودتر آن را برای مستقر کردن «ابررایانهٔ MareNostrum» آماده کنند، مثل اینکه به آنها الهام الهی شده باشد! کلیسای کوچک Torre Girona را به مرکزداده تبدیل کردند.

این ساختمان قدیمی برای مستقر کردن ابررایانه جای کافی داشت، اما زیرساخت فیزیکی لازم را نداشت. زیرا تاسیسات این مرکزداده در زمان خود پنجمین ابررایانهٔ سریع دنیا بهشمار میرفت. گزارشهای موجود نشان میدهد ابررایانهٔ MareNostrum که بیش از ۱۰٬۰۰۰ پردازشگر دارد، میتواند در ثانیه تا ۹۴ تریلیون عملیات انجام دهد. از این ابررایانه برای انجام کارهای محاسباتی سنگین (مانند تحقیق بر روی ژنوم انسان، شبیهسازی کیهان، بازسازی چگونگی پیدایش جهان) استفاده میشود.

چالش طراحان و سازندگان در این پروژه این بود که ساختمان قدیمی نود سالهای را برای کارکردن مرکز ابررایانش فوق مدرن بازسازی کنند. با این حال بههیچوجه نباید معماری خاص کلیسا تغییر میکرد. حاصل کار آنها ساختمانی است که اغلب آن را یکی از زیباترین مراکزدادهٔ جهان میشناسند.

دکتر سرخیو خیرونا (Sergio Girona) مدیر عملیات مرکز ابررایانش بارسلونا دربارهٔ دشواریهای ساخت این مرکزداده توضیح میدهد.

مشخصات تاسیسات:

- سازمان: مرکز ابررایانش بارسلونا [2]

- مکان: بارسلونا، اسپانیا

- شروعبهکار: فروردین ۱۳۸۴ (آوریل ۲۰۰۵)

- ویژگیهای چشمگیر: استقرار ابررایانهٔ MareNostrum ـ[3] در مرکزداده در داخل کلیسای کوچک قدیمی نود ساله

- مدت طراحی و ساخت: ۷ ماه

- مساحت: زیربنای کل کلیسا نامشخص، سالن حدود ۱۶۰ متر مربع

- برق: ۱٫۴ مگاوات برای همهٔ تاسیسات، ۸۶۰ کیلووات برای سختافزارهای رایانشی

- رتبهبندی: نامشخص

- تعداد رک: ۴۸

- ظرفیت برق: در هر رک متفاوت، حداکثر ۲۲ کیلووات برای هر رک

- زیرساختها: کابلهای برق، کانالهای سیستم سرمایش، کابلهای داده همگی در کف کاذب

- بار سازهای: ۲٬۵۰۰ کیلوگرم بر متر مربع

- سیستم اطفای حریق: سیستم «غبار آب» (Water Mist)

متن مصاحبه

الگر: چه شد که مرکز ابررایانش را در کلیسا ساختید؟

خیرونا: دولت اسپانیا موقعیت خرید ابررایانهٔ MareNostrum را در سال ۱۳۸۳ بهدست آورد. یک گروه بزرگ پژوهشی که در «دانشگاه فنی کاتالونیا» روی ابررایانش کار میکردند، از سال ۱۳۵۹ همکاری بسیار خوبی با شرکت IBM داشت. همین موضوع امکان خرید این سیستم را برای دولت اسپانیا فراهم آورد. پس از آن توافق شد که سیستم در جایی بسیار نزدیک به گروه پژوهشی (در دانشگاه فنی) و ظرف مدت ۴ ماه راهاندازی شود. همان طور که میدانید راهاندازیکردن سالن سرور جدید در ۴ ماهه به ساختمان آماده نیازمند دارد؛ ساختمانی آماده با تجهیزات خاص خودش. در آن زمان جاهای چندانی برای انتخاب نداشتیم که یکی از آنها این کلیسا بود؛ با ۱۲۰ متر مربع مساحت، بدون ستون و با بیش از ۵ متر ارتفاع سقف. با این ویژگیها یکی از مکانهای ممکن برای این کار و در واقع بهترین گزینه بود.

الگر: ابررایانه را باید ۴ ماهه نصب میکردید، چقدر زمان برای طراحی و ساخت داشتید تا بتوانید مرکزداده را مستقر کنید؟

خیرونا: این کار ماجرایی داشت. قرارداد بین دولت اسپانیا و IBM در ۲۰ اسفند ۱۳۸۲ امضا شد. هدف IBM این بود که سیستم را در آبان سال بعد در کنفرانس ابررایانش بهنمایش بگذارد. به همین دلیل این محدودیت ۴ ماهه اهمیت داشت. در ۲ فروردین ۱۳۸۳ یک حملهٔ تروریستی وحشتناک در مادرید رخ داد که کشتهٔ بسیاری داشت و مردم خواستار تغییر دولت در کاتالونیا و اسپانیا شدند. این حادثه باعث شد در کار ساخت سالن سرور ۳ ماه تاخیر اجباری داشته باشیم. ما از این زمان ۳ ماهه برای طراحی تاسیسات و بررسیهای آن استفاده کردیم. چیزی نمیساختیم، فقط تصمیمها را میگرفتیم و تحلیل و محاسبه میکردیم.

بعد از چند ماه خبر دادند که باید ساختن تاسیسات را شروع کنیم. کار ساخت را در تیر ماه ۱۳۸۳ آغاز کردیم و تاسیسات در ۲۱ مهر همان سال بهطور کامل آماده شد. بهدلیل تاخیر پیشآمده نمیتوانستیم تمام سیستم MareNostrum را تا اول مهر نصب کنیم که بتوانیم در Top500 شرکت کنیم. برای شرکت در Top500 بخشی از سیستم را در مادرید نصب کردیم و IBM هم امکاناتی برای دولت اسپانیا فراهم کرد تا بتواند آن بخش از سیستم را به کار اندازد. امکان عملیاتیکردن کل سیستم وجود نداشت. بنابراین تنها آن اندازه که برای اجرای آزمایش Linpack مناسب و کافی باشد نصب شد.

Top500 سریعترین ابررایانههای جهان را رتبهبندی میکند. برای این کار از روشی بهره میگیرد که با نام «معیار Linpack» معروف است. در این روش سرعت عمل ممیز شناور کامپیوتر با اجرای برنامهای محاسبه میشود که یک سری معادلات خطی را حل میکند. Top500 سالیانه دو بار تجدید نظر و بهروز میشود: یک بار در کنفرانس بینالمللی ابررایانش (ISC) اروپا در تیر ماه و یک بار هم در کنفرانس ابررایانش ایالات متحده در آبان ماه. |

پس بهطور خلاصه طراحی سیستم در فروردین ۱۳۸۳ آغاز شد و تا تیر ماه ادامه داشت. ساختوساز نیز از تیر تا مهر طول کشید. این شامل خود سالن سرور، تاسیسات سایت با سوئیچهای کنترل و آژیرهای خطر و سیستمهای تشخیص حریق، همچنین مبدلهای الکتریکی بوده است. ما چون به جریان برق فشار متوسط وصل هستیم باید آن را به ولتاژ عادی تبدیل کنیم.

الگر: حتی با در نظر گرفتن تاخیر پیشآمده، زمان برای انجامدادن آنهمه کار نسبتا کم است.

خیرونا: کاملا درست است. ضمنا این کار با شروع تعطیلات تابستانی در اسپانیا همزمان شد. باید بدانید در اسپانیا و کلا در جنوب اروپا تابستان گرما است و سخت میتوان افراد عادی را بهکار واداشت. تقریبا همه در تعطیلات هستند. بنابراین تابستانها قبل از شروعبهکار باید همهٔ چیزهایی را که نیاز دارید تهیه کنید وگرنه هیچ لوازمی نخواهید داشت.

الگر: روشن است که معمولا کلیسا جای مرکزداده نیست. برای قرار دادن محیط سرور در بخشی از ساختمان کلیسا، با چه محدودیتها یا چالشهایی روبهرو بودید؟

خیرونا: اول این بود که نمیخواستیم ساختار کلیسا را تغییر بدهیم؛ یعنی کلیسا دیوارهای خودش را داشت و ما هیچ دیواری را تغییر ندادیم. دوم اینکه کلیسا را برای رفتوآمد آدمها ساختهاند نه برای ماشینآلات. بنابراین با محدودیتهای سختی در اندازهٔ تجهیزاتی که وارد کلیسا میشوند روبهرو هستیم. ما فقط از یکی از درها میتوانیم برای آوردن لوازم استفاده کنیم؛ چون بقیه درها را بهاندازهٔ آدمها ساختهاند و دستگاههای بزرگ از آن رد نمیشوند.

ویژگی مهم دیگر این است که چون در گذشته در کلیساهای اسپانیا و اروپا از کف دودکشدار [4] برای گرمکردن فضاهای داخلی استفاده میکردهاند، پوستهٔ رویی کف آنها ضخامت و مقاومت کافی را برای تحمل وزن خیلی سنگین ندارد. پس مجبور شدیم تجهیزات را پس از بازسازی و مقاومسازی روی کف بگذاریم.

مسئلهٔ مهم دیگر این بود که سقف کلیسا بهاندازهٔ کافی ضخیم و مقاوم نبود تا چیلرها را روی آن بگذاریم. پس مجبور شدیم آنها را زیرزمین کنار کلیسا جا بدهیم. از نظر کارشناسان در آمریکا این راهکار خیلی عجیبی است، چون اگر گردبادی در راه باشد میتوانید روی چیلرها را بپوشانید تا هیچ خرابی به بار نیاید. ولی در اسپانیا گردباد وجود ندارد و وارد کردن هوای تازه به این زیرزمینها بسیار سختتر خواهد بود. این یکی دیگر از شرایط چالشبرانگیز بود.

الگر: آیا تغییر و اصلاحی در ساختار ساختمان صورت گرفت؟ به نظر میرسد خیلی تلاش کردهاید ساختمان را به همان حالت اولیه نگه دارید.

خیرونا: تنها تغییری که صورت گرفت سه یا چهار کانال است که از سالن اصلی به سرسرای کلیسا وصل میشوند؛ یعنی جایی که تجهیزات در آن است. یک کانال بزرگ هم برای چیلرها است که به بیرون وصل شده است. این کانالها را نمیتوان دید چون زیر زمین هستند.

الگر: چه توصیهای برای کسانی دارید که میخواهند در جایی شبیه به اینجا مرکزداده بسازند؛ یعنی جایی که تا حد امکان نباید کوچکترین تغییری در آن بدهند.

خیرونا: توصیه من هماهنگی کامل و برنامهریزی درست بین همهٔ کسانی است که روی ساختمان کار میکنند. ممکن است در آخرین لحظات بفهمید که کسی میخواهد کاری بکند که موازیکاری است و دیگر وقت انجامش گذشته. چون هرکس به زمینهٔ تخصصی خودش فکر میکند و نه به زمینهٔ تخصصی دیگران.

مثلا همزمان که کانالها را برای کابلکشی نصب میکردیم، دیگران به نصب تیرچهها و شیشهٔ سالن سرور فکر میکردند. اما فقط یک فضا برای حرکت جرثقیل وجود داشت که همان فضای کانالها بود. یعنی کارتان را باید خودتان و بهگونهای کاملا مناسب تنظیم کنید؛ مستقل از مهندسانی که در قسمتهای مختلف پروژه کار میکنند.

ما در کلیسا محفظهٔ شیشهای را داریم که زیر نظر یک معمار کار میشد. در داخل آن نیز ساختمانی را داریم که یک مهندس ادارهاش میکرد. این دو نفر با هم دوست بودند اما نه آنقدر که با هم ناهار بخورند. منظورم این است که با هم تبادل نظر میکردند ولی دیدگاهشان فرق داشت. چنین اشخاصی نظرات و دیدگاههای مختلفی دارند که هرگز به هم منتقل نمیکنند. کسی باید اینجای کار را در نظر بگیرد.

تصویر: مرکز ابررایانش بارسلونا در محفظهٔ شیشهای بزرگ با چشمانداز خوب از فضای کلیسا

الگر: صحبت از محفظهٔ شیشهای شد، به چهدلیل مرکزداده را بدین شکل محصور کردید؟

خیرونا: وقتی مراحل ساخت تکمیل شد، کارشناس معماری کلیسا گفت که جایگاه اصلی و داخل کلیسا نباید با اسباب و لوازم زیاد پر شود. نمیخواستیم هیچچیز را در کلیسا تغییر بدهیم؛ اگر برای کارمان از دیوار استفاده میکردیم نمای کلیسا بهکلی خراب میشد. اکنون این دیوارهای ما از شیشهاند و همهچیز را بهخوبی میتوان دید. بنابراین کلیسا همان طور که باید مانده است.

این کار دلیل دیگری هم دارد. به کامپیوترهایی که در اینجا نصب کردهایم در اسپانیا PC میگوییم که مخفف Portable Computer است. به همین دلیل این مکان را «Pecera» نامیدیم، چون محل قرار گرفتن PCها است. ولی «Pecera» در زبان اسپانیایی بهمعنی «تنگ ماهی» است. همان طور که میبینید این محفظهٔ شیشهای شبیه تنگ خیلی بزرگی برای کامپیوتر است.

معمولا سالنهای کامپیوتر پنجره دارند. آنهایی که در آمریکا ساختهاند نه. اما در منطقهٔ ما معمولا پنجره دارند برای اینکه بتوان داخلشان را دید. در عوض ما اینجا تنگ ماهی بزرگی برای سالن سرور داریم که همهجایش هم پیدا است.

این روش هم زیبایی بصری دارد و هم از دید معماری باعث میشود مرکزدادهٔ ما کمنظیر باشد. استفاده از دیوار معمولی که مانع از دیدن محیط داخلی کلیسا میشد راهکار خوبی نبود. حتما دیوارهای کلیسا را دیدهاید، راهکار خوبی نبود، چون روی دیوارها ستونهایی قرار میگیرد که باید آنها را برای کار سرمایش سیستم از بین میبردیم.

الگر: این مرکز ابررایانش چهمیزان افزونگی برای زیرساخت دارد؟

خیرونا: افزونگی هم داریم. اما توجه کنید که در اسپانیا این مرکز کامپیوتر ویژهٔ دانشمندان است و هیچ محدودیتی برای عرضهٔ خدمات به آنان وجود ندارد. ما در قراردادهای خدماتی خود برای خدماتگیرندگان هیچ شرایط سختی در نظر نمیگیریم. به همین دلیل هم تصمیم گرفتیم که در تمامی بخشها افزونگی کمتری داشته باشیم. مثلا برای سرورها و برای ارتباط شبکهای با بیرون فقط از یک UPS و یک ژنراتور استفاده میکنیم. این درست است که اگر خرابی پیش بیاید بهراحتی تمام ظرفیت رایانشی را از دست میدهیم، اما ما براساس نیازهایمان و هزینهٔ کل مالکیت سیستم با راهکاری متفاوت دراینباره تصمیمگیری کردهایم.

الگر: همهٔ زیرساخت برق، سیستم سرمایشی، کابلکشی، در کف کاذب قرار دارند. درست است؟

خیرونا: بله. هریک از رکها ۲۲ کیلووات برق مصرف میکند. آن اوایل سیستم سرمایش با CRAC ـ[5] بود، پس تصمیم گرفتیم ۹۷ سانتیمتر زیر کف داشته باشیم و همهٔ تجهیزات و کانالها را به زیر کف کاذب منتقل کنیم.

«استفاده از دیوار معمولی که مانع از دیدن محیط داخلی کلیسا میشد راهکار خوبی نبود.»

ما لولهکشی آب سرد داریم که نیاز ۱۲ واحد CRAC را تامین میکند. این CRACها برای سیستم سرمایش ۱٫۱ مگاوات ظرفیت فراهم میکنند. دمای آب سرد را با توجه به تابستان و زمستان تغییر میدهیم. معمولا در زمستان با آب گرمتر و در تابستان با آب سردتر کار میکنیم.

همچنین برای برق و شبکه از زیر همکف کانالکشی کردهایم. این کانالکشیها در سطوح مختلف و برای کارهای مختلف در زمینههای مختلف است: برای برق، برای اترنت مسی، دیگری هم برای فیبر. سعی کردهایم دالان هوای گرم را خالی نگه داریم، به همین دلیل تمام کانالها را از زیر کف دالان عبور دادیم.

وزن رکهای کامپیوتر را در نظر بگیرید؛ کف را طوری طراحی کردهایم که وزن ۲٬۵۰۰ کیلوگرم بر متر مربع را تحمل کند. این امروزه استاندارد است ولی در آن زمان نبود. تصمیم گرفتیم همهٔ کف را با همین تحمل وزن بسازیم. ولی از طرفی در تجزیهوتحلیل از دید دینامیک سیالات، برای میزان هوایی که باید از سوراخهای کاشیهای کفپوش خارج میشد ناموفق بودیم.

برای حل این مشکل اول قسمتی از کاشیهای جلوی ورودی رکها را برداشتیم تا هوای خنک بیشتری به محیط برسد. سپس من محفظهای طراحی کردم. آن را روبهروی رک گذاشتیم تا تمام هوایی را که از کف کاذب بیرون میآید یکراست به داخل سرورها هدایت کند. ظاهرا شبیه دودکش است، اما کارش این است که هوای سرد را مستقیم به داخل رک بفرستد.

بنابراین دیگر دالان هوای سرد را نداریم؛ چون دالان هوای سرد با این روش محدود شده است. اکنون همهٔ سالن سرور گرم است. میانگین دمای هوای سالن سرور الان ۳۲ درجه سانتیگراد است. البته قبلا ۳۴ درجه بود که آن را با مبادله با بیرون از کلیسا کاهش دادهایم. به همین دلیل کسانی که تابستان برای بازدید به اینجا میآیند از گرمایی که خارج میشود شکایت میکنند.

تا آنجا که من میدانم، ما اولین سالن سرور را داشتیم که به جای سرد، گرم بود. دمای هوا را تا ۱۸ درجه سانتیگراد کاهش میدهیم؛ اما هوای سرد فقط محدود به رک کامپیوتر است و مستقیم همان جا میرود. این هوا با دالان هوای سرد بسته مبادله نمیشود، بلکه کاملا به کامپیوتر وصل است. [بهعبارت دیگر در چرخهٔ هوای رفت همانند سیستم سرمایش رک بسته و در چرخه برگشت همانند سیستم سالنی سنتی است. (مطالعهٔ بیشتر)]

الگر: چه باعث شد که حداکثر دمای مرکزداده را گرمتر در نظر بگیرید؟

خیرونا: بهرهوری بیشتر. مشکل من کمبود اختلاف دما برای واحدهای CRAC بود؛ چون اختلاف دما از ۳ تا ۴ درجهٔ سانتیگراد بیشتر نمیشد. اکنون اختلاف دمای بالاتر از ۱۲ درجه سانتیگراد داریم. در نتیجه واحدهای CRAC برای سرورها با عملکرد مناسبی کار میکند. CRAC برای کار در چنین شرایطی طراحی شده است و ما این وضعیت را حفظ میکنیم. اگر سالن سرور سرد باشد، هوای سرد به واحد CRAC برمیگردد و اختلاف دما کافی بهوجود نخواهد آمد. به همین دلیل نیز واحدهای CRAC عملکرد خوبی نخواهند داشت و با بهرهوری کمتری کار خواهند کرد. [مطالعهٔ بیشتر]

با این تجهیزات و با کار در دمای بالاتر میتوانیم کاری کنیم که «فن» در همهٔ کامپیوترها با کمترین سرعت کار کند. همچنین میتوانیم فن همهٔ CRACها را برای کار در سرعت بسیار پایین یعنی ۷۰ یا ۸۰ دور در دقیقه تنظیم کنیم. چنانچه تجربهٔ چنین کاری را داشته باشید میدانید که اگر فن با ۸۰ درصد ظرفیت کار کند، فقط ۵۰ درصد انرژی مصرف میکند. چنین نتیجهای واقعا هزینهٔ برق من را کم کرد. در حقیقت یکی از چیزهایی که بعد از سروسامان دادن این کارها بهدست آوردیم این بود که صورتحساب برق تا ۱۰ درصد کاهش یافت. میخواهم بگویم که هزینهٔ برق ما سالانه حدود یک میلیون یورو است که ۱۰ درصد کاهش هم پول زیادی میشود.

هر کس دیدگاه خودش را دارد؛ مهم این است که باید آن را بهطور واضح طراحی کند. در جاهای دیگر برای ثابت نگهداشتن شرایط محیط معمولا سیستمهای تهویهٔ مطبوع خودشان را سازگار میکنند. نکته در کار ما این است که برعکس هیچ تغییری در سیستم نداریم. سیستم ما تمام روز و با همهٔ توان کار میکند. هیتری داریم که ۲۴ ساعته کار میکند تا دما را از ۱۸ به ۳۲ درجه افزایش دهد؛ هر روز و هر لحظه. از آنجایی که ساختمانی که سالن سرورمان در آنجا است ساختمان معمولی است، شرایط را تغییر نمیدهیم و آن را در شرایط بسیار پایدار نگه میداریم.

الگر: به نظر میرسد شما زیاد تغییری در سختافزارهایتان نمیدهید. آیا مجموعهای مشخص از تجهیزات را در مدت طولانی تعمیر و نگهداری میکنید، یا ابررایانه و سختافزارهای آن را بهطور منظم ارتقا میدهید؟

خیرونا: معمولا مجموعه را تا کمتر از ۶ ماه تغییر نمیدهیم. در هر شش ماه فقط ممکن است یک رک وارد مجموعه شود و یک رک قدیمیتر خارج شود. خلاصه کار خاصی نمیکنیم. سالن سرور ما مخصوص رایانش سنگین است، سیستمهایی که کارهای دیگر میکنند در ساختمانهای دیگر هستند.

تصویر: ابررایانهٔ MareNostrum در مرکز ابررایانش بارسلونا، دارای بیش از ۱۰٬۰۰۰ پردازشگر، با قدرت ۹۴ تریلیون محاسبه در ثانیه

الگر: از چهنوع سیستم اطفای حریقی استفاده میکنید؟

خیرونا: من به دو دلیل بهشدت با استفاده از هر نوع سیستم گازی مخالفم. اول برای سلامتی افرادی که در سالن سرو هستند. هرچند تعداد افرادی که میتوانند وارد شوند بسیار محدود است. چون همهچیز را میتوان از بیرون دید و معمولا نیازی نیست کسی داخل باشد.

دلیل دیگر قوانین هستند. در اروپا قوانین دربارهٔ اینکه چه گازی را میتوان برای اطفای حریق استفاده کرد مرتب تغییر میکند. بنابراین سراغ «غبار آب» یعنی ذرات بسیار کوچک آب رفتیم. در این روش برای اطفای حریق از ذرات بسیار کوچک آب استفاده میکنند که سرعت و شتاب زیادی دارند.

برای دیدن طرز کار این فناوری با تولیدکنندگان سیستم غبار آب در جایی ملاقات کردم. آنها محیطی را به من نشان دادند که در آن یک PC دو بار در روز در معرض غبار آب قرار میگرفت ولی اتاق کامپیوتر همچنان کار میکرد. نتایج آزمایشها برایم جالب بود.

چیز جالب دیگر این بود که گازوئیل را داخل مخزنی آتش زدند. با استفاده از آب معمولی سه دقیقه طول کشید که آتش خاموش شود، آن هم وقتی که دیگر گازوئیل کاملا سوخته و تمام شده بود. اما وقتی همین آزمایش را با غبار آب انجام دادند، آتش در ۱۵ ثانیه خاموش شد. در حالی که هنوز گازوئیل وجود داشت، چون به من نشان دادند که میتوانند دوباره آن را آتش بزنند. پس این سیستم آتش را با وجود مادهٔ سوختنی که هنوز تمام نشده بود خاموش کرد. این از نظر من خیلی خوب بود.

از سویی وقتی مخازن آن خالی میشود، شارژ کردنش خیلی پر هزینه نیست. این در مقایسه با سیستم گازی که شارژ دوبارهاش بسیار گران درمیآید مزیتی است. چون فقط آب معمولی در آن است که با شیوهای متفاوت کار میکند. مسلما هزینه دارد، اما قیمت شارژ دوبارهٔ آن بهاندازهٔ یکدهم شارژ سیستم گازی است.

الگر: اگر میتوانستید به گذشته برگردید و مرکزداده را از اول بسازید، آیا چیزی در طراحی آن هست که بخواهید تغییر دهید؟

خیرونا: با فناوری امروزی، بله حتما. برای مثال اکنون ما داریم ساختمان را طوری تغییر میدهیم که تا بشود رکها را با هوا یا از طریق درهای عقب خنک کنیم. یعنی هر دوی این روشها را در یک ساختمان داشته باشیم. غیر از اینها چیز زیادی نیست که بخواهم تغییر دهم.

الگر: منظورتان درهای عقبی است که با مایع خنک میشوند؟

خیرونا: بله. ما برای تعداد رکها در سالن سرور محدودیت داریم. چون فقط برای ۴۸ رک در سالن سرور جا هست. این محدودیت بهدلیل فضای ضروری است که برای جریان هوا در دالانهای هوای گرم نیاز داریم. کمکردن فضای دالان باعث میشود بسیار تنگ و داغ شود. اگر بخواهیم یک ردیف یعنی ۸ رک دیگر داشته باشیم، تنها راه ممکن این است که رکها را با آب خنک کنیم و این بهوسیله درهای عقبی امکانپذیر است. [مطالعه دربارهٔ طراحی سالن]

برای این کار اول تاسیسات را ارتقا میدهیم، برای اینکه بتوانیم بیشترین تعداد رک مجهز به سیستم سرمایش درهای عقب را داشته باشیم. سپس ظرفیت برق و سیستم سرمایش کل سالن سرور را افزایش میدهیم.

الگر: برای این کار باید برق بیشتری استفاده کنید، یا همین ظرفیت الکتریکی که اکنون دارید امکان استفادهٔ بیشتر را دارد؟

خیرونا: البته من ظرفیت برق را افزایش میدهم ولی مصرف هم بیشتر میشود. اکنون مصرف برقمان جمعا ۱٫۳ یا ۱٫۴ مگاوات است و پیشبینی میکنم که این مقدار در کل تا ۲ مگاوات افزایش یابد. ولی ظرفیت بیشتری را هم برای پشتیبانی اضافه میکنیم؛ یعنی رویهمرفته حدود ۴ مگاوات برق تامین میکنیم. اما تصمیم من این است که مصرفمان حداکثر ۲ یا ۲٫۱ مگاوات باشد.

روش کار برای سیستم سرمایش هم مشابه است. همان میزان برق را مصرف میکنیم ولی ظرفیت را افزایش میدهیم تا افزونگی داشته باشیم. تصمیم داریم ظرفیت کل را افزایش بدهیم؛ بنابراین بهجای داشتن رکهای ۲۲ کیلوواتی بهدنبال رکهایی هستیم که تا ۲۸ کیلووات ظرفیت داشته باشند.

الگر: در حال حاضر خیلی از زیرساختهای فیزیکی در سایت وجود دارد؛ اما باز هم مجبورید داخل ساختمانی که نباید تغییری در آن بدهید کارهایی بکنید. اگر به عقب برگردید و دوباره طراحی کنید، آیا این مسئله بر شیوهٔ ارتقای شما تاثیر میگذارد؟

خیرونا: بله کاملا. اول از همه با دقت به برنامهریزی دربارهٔ تمام لولهکشیها و تجزیهوتحلیلها و کنار گذاشتن سیستمهای قدیمی و نصب سیستمهای جدید فکر میکنم. این کار باید خیلی دقیق و برنامهریزیشده باشد. البته هر سیستم جدید باید گزینهٔ مبدل برودتی درهای عقب (RDHx) را داشته باشد، چون نمیتوانم تعداد زیادی رک را در سالن سرور جا بدهم. این مسئله برای همهٔ کامپیوترهای جدید در سالن سرور الزامی خواهد بود. همین موضوع شامل دیسکها هم میشود. زیرا دیسکهای فعلی ۵ کیلووات برق مصرف میکند ولی دیسکهای جدید که در حال نصب آنها هستیم، ۱۵ کیلووات مصرف میکند. این مقدار گرمای زیادی است که باید از رک خارج شود.

الگر: بدیهی است که خود کلیسا ظرفیت برق کافی را برای مصرف ابرکامپیوتر نداشته است. ظرفیت لازم را چگونه فراهم کردید؟

خیرونا: برق خود کلیسا ظرفیتی را که نیاز داشتیم اصلا نداشت. نورپردازی مختصری داشت که خیلی قوی هم نبود. ما در سالن بزرگی که در سال ۲۰۰۴ در این انبار کنار کلیسا ساخته شد، ترانسفورماتورهایی را نصب کردیم که ظرفیت برق بهدست آمده از آنها برای مصرف سالن سرو کافی است. آنجا ۳ مبدل با ظرفیت برق کافی نصب شده که به جریان ولتاژ متوسط دانشگاه متصل است. میتوانیم از آن ۳ مگاوات برق بگیریم که البته میخواهیم آن را به ۴ مگاوات افزایش بدهیم.

الگر: تحمل «بار سازهای» (Structural load) کلیسا چقدر است؟ روشن است که این ساختمان از ابتدا تحمل چنین وزنی را نداشته است. این سختافزارهای کامپیوتری بسیار سنگین هستند.

خیرونا: غیر از قسمتهایی که قبلا گفتم کف دودکشدار داشت و کاملا آنها را بازسازی کردیم، بقیهٔ جاهای کلیسا همسطح زمین است. بدین معنی که تمام وزن کلیسا روی خود زمین قرار دارد و پایدار است؛ پس مشکلی ایجاد نمیکند. اینجا وزن ۲٬۵۰۰ کیلوگرم بر هر متر مربع را تحمل میکند.

الگر: آیا برای تقویت جایی که ابرکامپیوتر در آنجا مستقر شده کار خاصی کردید، یا همان زیرساخت اولیه برایش مناسب بود؟

خیرونا: آنجا هم مناسب بود. غیر از قسمتهایی که کف دودکشدار داشت همهچیز خوب بود. بنابراین ما روی همین کف ساختوساز کردیم که همسطح با زمین است.

الگر: آیا در طی پروژه اتفاقات غیرمنتظرهای هم پیش آمد؟

خیرونا: نه، واقعا نه. فقط مشکلات معمولی بود، همین مشکلاتی که همه میشناسند اما هیچکس نمیداند چطور آنها را حل کند.

مثلا رطوبت. ما ۱۲ واحد CRAC داریم که بهدلیل تغییر دما همیشه در حال رطوبتسازی هستند. اگر بخواهید جداگانه رطوبت تولید کنید، بسیار پرهزینه است و هزینهٔ برق آن سهبرابر هزینهٔ برقی است که واحد CRAC مصرف میکند. اگر جداگانه رطوبتسازی نکنید، در هزینه بسیار صرفهجویی خواهد شد. نکته در این است که بهراحتی میتوان رطوبتسازی کرد.

نمیدانم که شما در کوهستان زندگی میکنید یا ساحل. در مناطق کوهستانی مردم برای بهدستآوردن رطوبت تنها کاری که میکنند این است که ظرف آب را روی رادیاتور میگذارند. این کار آب را به دمای تبخیر میرساند و رطوبت تولید میشود. ما هم در سالن سرور با مشکل کمبود رطوبت روبهرو میشویم که گاهبهگاه به همان ترتیب با ظرفهای آب برطرف میکنیم. بدین شکل صرفهجویی قابل ملاحظهای در هزینهها بهدست میآوریم. این چیزی است که میتوان از طبیعت یاد گرفت. در طبیعت رطوبت از دریا و خورشید ناشی میشود و به محیط راه پیدا میکند.

الگر: مرکز ابررایانش شما را چندین نشریه و وبسایت از جملهٔ زیباترین مراکزدادهای توصیف کردهاند که تاکنون ساخته شده است. هنگام ساختن آن چقدر به ظاهر ساختمان اهمیت میدادید؟ آیا آگاهانه به جنبههای زیباییشناسی توجه کردید، یا این ظاهر جالب بهشکل اتفاقی از طراحی بهدست آمد؟

خیرونا: بیشتر ناخواسته بود. دلیل این ظاهر زیبا این است که تجهیزات را درون کلیسا نصب کردهایم ولی نمیخواستیم در ساختمان کلیسا تغییر بدهیم؛ میخواستیم معماری کلیسا پیدا باشد. سالن سرور بهخودیخود و بهتنهایی زیبا نیست؛ مجموعهٔ سالن سرور و کلیسا با هم زیبا شدهاند. همچنین به این موضوع توجه کنید که ما هیچچیز را در کلیسا تغییر نمیدهیم و کامپیوترها را با تمام ظرفیت بالا و عملکرد خاصی که دارند، در فضایی با معماری کلیسایی بهکار گرفتهایم.

تصویر: ارتفاع سقف شیشهای مرکز ابررایانش بارسلونا، متناسب با ابعاد کلیسا برای جریان هوا بهینه شده است.

بیشک فضای سالن سرور را برای بیشترین بهرهوری سرمایش طراحی کردهایم. اگر به عکسها نگاه کنید متوجه میشوید که بیشتر تیرهای ساختمانی سالن سرور بیرون از آن قرار دارند نه در داخل آن. به این علت که بر جریان هوای سالن از دید دینامیک سیالات تاثیر منفی نگذارد.

همچنین سالن را به همان دلیل سرمایشی که گفتم طوری طراحی کردهایم که به جای ۳ یا ۴ متر، ۵ متر ارتفاع داشته باشد. این کار ارتفاع کل سالن شیشهای را با ابعاد کلیسا همسان کرده و سقف سالن سرور با طبقهٔ بالای کلیسا همسطح شده است. بدین شکل علاوه بر جنبهٔ کاربردی، میان کلیسا و سالن سرور، اندازه و تقارنی هماهنگ بهوجود آمده که نما و محیط را بسیار خوشایند کرده است. این کار هم برای سالن سرور و هم برای نمای ساختمان بسیار مناسب است.

الگر: پس به نظر میرسد وقتی تصمیم به ساختن این سالن کامپیوتر در کلیسا گرفتید، با اینکه محدودیتهایی در دستکاری ساختمان وجود داشت، طراحی خوب پیش رفت. یعنی شما نمیخواستید این مرکزداده حتما نمونهٔ زیبا و برجستهای باشد، اما چون در کلیسا بود به نمونهٔ برجسته تبدیل شد.

خیرونا: درست است. وقتی متخصصان فهمیدند که این تاسیسات باید داخل کلیسا باشد، معماران ما با این چالش مواجه شدند که نباید کلیسا خراب بشود و برعکس قرار بود تمام زیباییهای آن دیده هم بشود. چالش مهندسی در کار توسعه، نصب سیستم تهویهٔ مطبوع بود. زیرا در طراحی چنین مرکزی باید همهچیز بسیار کارآمد باشد ولی داخل کلیسا چنین نبود.

ما میخواستیم معماری داخلی کلیسا را بشود دید؛ بنابراین همهچیز را متناسب با محیط و شفاف طراحی کردیم. تمام بخش زیرین سالن سرور از بیرون پیدا است. به همین دلیل باید همهٔ کانالها مرتب نصب و برچسبگذاری شوند و همهچیز با دقت سر جای خودش قرار بگیرد.

هر روز از دانشگاهها و از مدارس و همچنین از سیاستمداران بازدیدکنندگانی داریم که در واقع برای بازدید از کلیسا به اینجا میآیند. این برای ما هم بسیار خوب است. زیرا به این ترتیب میتوانیم کارمان را نمایش بدهیم؛ اینکه با این کامپیوتر چه میکنیم و دانشمندان با این مرکز چه کارهایی میکنند.

تصاویر دیگر از مرکز ابررایانش بارسلونا، بهترتیب از راست: محل استقرار رایانهٔ MareNostrum، محفظهٔ شیشهای «تنگ ماهی»

پانویس

[1] این مطلب ترجمهٔ بخش چهارم از کتاب «The Art of the Data Center» است. گفتوگوکننده داگلاس الگر (Douglas Alger)، مترجم پرواز خیّر، ویراستار پرهام غدیریپور، بهکوشش دکتر بابک نیکفام، تهیهشده در باشگاه مراکزداده

[2] Centro Nacional de Supercomputación

[3] دومین ابررایانه در اسپانیا که IBM آن را معرفی و عرضه کرد. این سیستم ۲۰ ترابایت حافظه و ۲۸۰ ترابایت فضای دیسک خارجی دارد.

[4] کف دودکشدار: فضاهای خالی که در کف ساختمان تعبیه میشدند (شبیه کف کاذب کنونی) و با عبور دادن دود آشپزخانه از درون آنها محیطهای داخلی را گرم میکردند.

[5] Computer Room Air Conditioning

درج دیدگاه