مرکزداده اینتل در شهر ریو رانچو [1]

آنچه میخوانید

شرکت اینتل این مرکزداده پیشرو را با بازسازی ساختمان قدیمیِ کارخانهٔ قطعات الکتریکی ساخته است. این مرکزدادهٔ ماژولار که آن را توسعهپذیر ساختهاند، بسیار پرظرفیت و پربازده است. مهندسان این تاسیسات توانستهاند در این پروژه از مرکزدادهٔ شِبه کلاس دو، عملکرد کلاس چهار به دست آورند.

ظرفیت بسیارِ این مرکزداده با بهرهگرفتن از فناوری چندهستهای اینتل ممکن شده است؛ چنانکه توسعه مییابد، ولی به افزایش فضا نیازی ندارد. آن را هنگامی ساختهاند که هنوز هیچکس تاسیساتی چنین پرظرفیت نساخته بود؛ از آنجا که تجهیزات و راهکارهای مناسب آن وجود نداشت، اینتل هرچه لازم بود خودش به وجود آورد.

برای فراهمساختن سرمایش آن، از رک بستهٔ هواکشدار که اختراع خود اینتل است و روش دالان گرم بسته استفاده کردهاند. به همین دلیل در سالنهای این مرکزداده هیچ نقاط داغ به وجود نمیآید. این تاسیسات بدون کف کاذب است و میتواند در دمای عملیاتی ۳۵ تا ۳۷ درجه کار کند.

آشنایی با مرکزدادهٔ اینتل در شهر ریو رانچو (Rio Rancho)

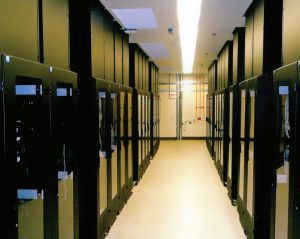

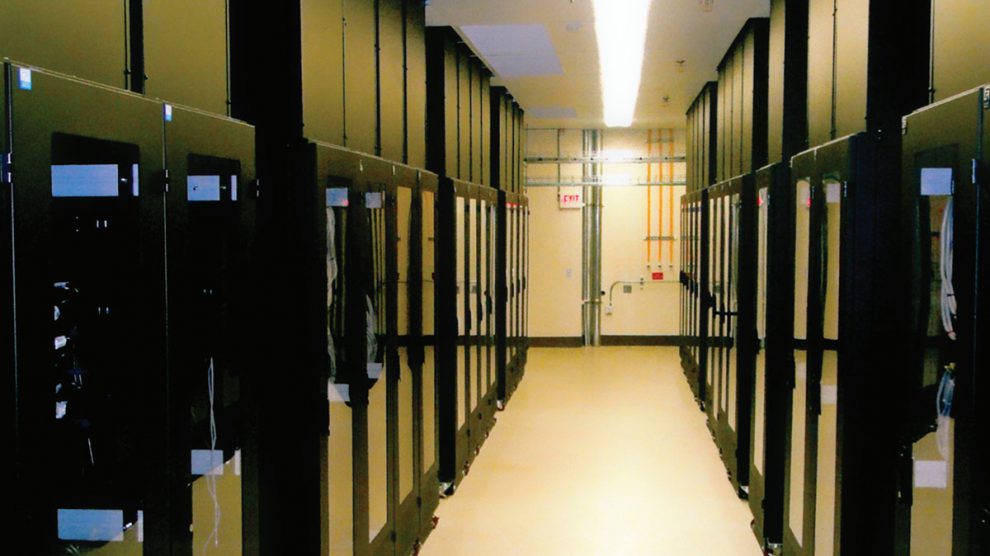

تصویر: استفاده از رکهای بسته با ظرفیت برق ۳۶ کیلووات بهازای هر رک و سرمایش با هوا

اینتل در نوآوری صنعت مرکزداده شناختهشده است. این شرکت اغلب از چهارچوبهای معمول فراتر میرود تا ببیند چگونه میتوان از زیرساخت فیزیکی و سختافزارها، بازدهی و عملکرد بیشتری در محیطهای سرور به دست آورد.

مهندسان این شرکت «رک بسته» را اختراع کردهاند تا بهرهوری سیستم سرمایش را بهبود بخشند. ساختمانهایی ساختهاند که از گرمای هدر رفته در سرورها دوباره استفاده کنند. حتی سختافزارها را چندین ماه در مکان مرطوب و غبارآلود به کار واداشتند، تا دریابند اگر برخلاف بیشتر مراکزداده، عملیات را بدون نظارتِ دقیق بر هوای محیط انجام بدهند، چقدر در انرژی صرفهجویی میشود و چنین وضعیتی بر اطمینانپذیری سرورها چه تاثیری دارد.

نتیجهٔ آزمایشهای این شرکت الگویی است از مرکزداده. این الگویی است که هم ظرفیت برق بسیار زیاد و سیستم سرمایشِ با هوای بهینه دارد، هم شبکه و رایانش و ذخیرهسازی و مولفههای تاسیساتی را شامل میشود.

اینتل در سال ۲۰۰۵ در ریو رانچو در ایالت نیومکزیکو، ساختمان ۲۵ سالهٔ کارخانهٔ تولید تراشهٔ سیلیکونی را برای مرکزداده بازسازی کرد. شرکت اینتل طراحی مرکزدادهٔ پربازده و پرظرفیت خود را برای نخستین بار در آنجا اجرا کرد. این مکان اکنون تاسیساتی است با ۶۲۳ متر مربع سالن سرور که بهدلیل ظرفیت برق ۸ مگاواتیِ ۳۶ کیلووات بر رک، بیش از ۲۲ هزار سرور را تنها در ۲۶۸ رک جای داده است.

در این ساختمان دو محیط سرور دیگر هم وجود دارد. یکی فضایی معمول است، با کف کاذبی بهمساحت ۳۷۰ متر مربع، با دالانهای هوای گرم و سرد، با ۷ الی ۱۰ کیلووات برق در هر رک. دیگری جایی است بهمساحت ۵٬۶۰۰ متر مربع. آن را خالی نگه داشتهاند تا ابررایانهٔ ۲۸ رکی و مجهز به سرمایشِ مایعِ ایالت نیومکزیکو را نصب کنند که Encanto نام دارد. بار کاری این ابررایانه وظایفی است همچون بررسی و نشاندادن جریان نشتِ نفت که در سال ۲۰۱۰ در ساحل خلیج مکزیک رخ داد.

آقای «دان اَتوود» (Don Atwood) که معمار کل مراکزدادهٔ اینتل است، توضیح میدهد چگونگی کارخانهٔ قدیمی را به مرکزدادهٔ پربازده تبدیل کردهاند. او پیشبینی میکند دمای عملیاتی و ظرفیت برق محیط سرورها در آینده بیشتر خواهد بود.

مشخصات تاسیسات

- نام سازمان: اینتل

- مکان: آمریکا، ایالت نیومکزیکو، ریو رانچو (Rio Rancho)

- شروعبهکار: ۲۰۰۶

- ویژگیهای چشمگیر: بازسازی ساختمان کارخانهٔ تولید ویفرهای الکتریکی و تبدیل آن به مرکزداده، اولین مرکزدادهٔ دارای رکهای مجهز به هواکش برای خارجکردن کامل هوای گرم و بهبود دادن بهرهوریِ سیستم سرمایش

- مدت طراحی و ساخت: ۲۰ ماه

- مساحت: حدود ۱٬۷۰۰ متر مربع، شامل حدود ۶۲۰ متر مربع سالن سرور

- برق: اتصالات افزونه به شبکهٔ توزیع برق، ظرفیت فاوای قابل استفادهٔ ۸ مگاواتی

- رتبهبندی: کلاس دو (Tier 2)

- تعداد رکها: ۲۶۸ رک

- ظرفیت برق: میانگین ۲۴ کیلووات در هر رک، حداکثر ۳۶ کیلووات

- زیرساخت: عبور کل تاسیسات از بالا، جدا بودن مسیر کابل مسی از مسیر فیبر، توزیع برق از باسبارهای موازی، بینیاز از کف کاذب

- سیستم سرمایش: سرمایش با هوا، بهوسیلهٔ رکهای بستهٔ دارای هواکش برای خارجکردن هوای گرم، جای هواسازها در طبقهٔ بالای سالن سرور

- بار سازه: ۹۷۶٫۵ کیلوگرم بر متر مربع

- سیستم اطفای حریق: سیستم آبفشان «لولهٔ تر» (Wet Pipe System) با سیستم تشخیص سریع دود VESDA ـ[2]

متن مصاحبه

الگر: چطور شد تصمیم گرفتید این ساختمان تولید ویفر الکتریکی را تبدیل کنید به مرکزداده؟

اتوود: با دگرگونی فناوریِ صنعت ساخت موادِ نیمهرسانا، فضای این کارخانه باید تغییر میکرد. الزامات ساخت اندازههای مختلف تراشه تغییر کرده بود و ساختمان و تجهیزات فیزیکی که برای ساختن این محصولات به کار میرفت، باید عوض میشد. این موضوع با توجه به کسبوکار، ما را ناچار کرد اینجا را خالی کنیم و کارخانه را جای دیگری ببریم. پس از جابهجایی، سالهای زیادی خالی بود. چندین سال برای اهداف داخلی گوناگون از آن استفاده میکردیم.

نیازهای ناشی از الزامات رایانشی اینتل، در سطح جهان روزبهروز بیشتر میشد. رشد اینتل در زمینهٔ مرکزداده از نظر فضا و سرمایش و برق بسیار بسیار زیاد است. ما کل فضایی را که در سطح جهان در اختیار داشتیم بررسی کردیم تا جایی را پیدا کنیم که برای ساختن مرکزداده مناسب باشد. با نظر به اینکه مخاطبان کجا هستند، پهنای باند و «تاخیر ارسال داده» (Latency) برای مراکزداده چه هستند، همچنین اینکه از نظر مالی ساختن مرکزدادهٔ سبز معقول است، یا بازسازی ساختمان قدیمی. ما با دید کلی بر تمامی امکانات اینتل در جهان، تحلیلی انجام دادیم. آنگاه نتیجه گرفتیم نیومکزیکو بهچندین دلیل واقعا جای خوبی است. اینجا از نظر موقعیت جغرافیایی و برق و اطمینانپذیری و هزینه از جاهای بسیار خوبی است که ما در جهان داریم. بهعلاوه این ساختمان را نیز داشتیم که بسیار خوب و ارتقا یافته است؛ ولی بیاستفاده مانده بود. بهجای اینکه در یکی از املاکمان مرکزدادهٔ سبز بسازیم، توانستیم از ساختمان این کارخانه دوباره استفاده کنیم.

اینجا هزینه و بهطور کلی ریسکِ بسیار کمتری نسبت به جاهای دیگر دارد. پس تصمیم گرفتیم بهجای ساختن بنای جدید، همین کارخانهٔ قدیمی خودمان را زنده کنیم. ما در سطح جهان ۱۵۰ سایت داریم و تقریبا هرجایی را که دلمان میخواست میتوانستیم انتخاب کنیم. با این حال از نظر مالی معقولتر بود که سراغ همین ساختمان کارخانهٔ قدیمی برویم؛ چون در ریو رانچو هزینهٔ انرژی ارزانتر و پایایی (Availability) برق بهتر است.

الگر: شما ساختمان موجود را بازسازی کردید. ویژگیهایی که از قبل در ساختمان بود، چه تاثیری بر طراحی مرکزداده داشت؟

اتوود: بهنظرم اگر مرکزداده را از نو ساخته بودیم، بیشک برخی کارها را جور دیگری انجام میدادیم. وقتی میخواهید ساختمان موجود را بازسازی کنید، با خودتان فکر میکنید که این سازهها و این دیوارها را داریم که پول خرجشان کردهایم. حالا چطوری از آنها بهترین استفاده را بکنیم؟ چیزی که مهم است، لزوما چگونگی طراحیِ ساختمان جدید نیست. این مهم است که با زیرساختی که هماکنون دارید باید چهکار بکنید.

در طراحی سنتی کارخانهها، همیشه طبقهٔ بالا جای تجهیزات مکانیکی است که به حجم زیادی از جریان هوای دائمی نیاز دارد. طبقهٔ وسط محیط تولید است. طبقهٔ زیرین نیز محل تاسیسات الکتریکی است. اینها سه بخش بزرگی هستند که هر مرکزدادهای نیاز دارد؛ یعنی فضای مرکزداده، فضای تجهیزات مکانیکی، فضای تجهیزات الکتریکی. بدین ترتیب ساختمان را از نظر توزیع برق، از همان ابتدا مناسب ساخته بودند. لولههای آب و تجهیزات الکتریکی نیز همه در جای درست و مناسب خود بودند. با خودمان گفتیم این چیزی که در اختیار داریم، نسبتا با آنچه در طراحی مرکزداده لازم داریم، همخوانی دارد.

تصویر: هواسازها در طبقهٔ سوم مرکزدادهٔ اینتل در ریو رانچو

تنها مسئلهٔ بزرگی که باید به آن توجه میکردیم، این بود که داشتیم اولین مرکزدادهٔ بسیار پربازده اینتل را میساختیم. در ابتدا معیار ما طراحی بیش از ۳۰ کیلووات در هر رک بود؛ ولی در نهایت آن را با ۳۶ کیلووات در هر رک به انجام رساندیم. بزرگترین نگرانی ما این بود که میخواستیم تجهیزات رایانشی را در طبقهٔ دوم جا بدهیم. طبقهٔ دوم در واقع طبقهٔ تجهیزات تولیدی کارخانه بود و ما نگران این بودیم که چنین وزنی را سازه تحمل نکند؛ چون رکهای سنگین و پرظرفیتی داشتیم. کارخانهها معمولا تجهیزات بسیار سنگینی دارند و ساختمانشان را مناسب این وزن میسازند. به همین دلیل مشکلی پیش نیامد و خیلی خوب کار کرد. لازم نشد در طبقه اصلاحاتی انجام بدهیم که توانایی تحمل وزن رکهای ۱٬۱۳۴ کیلوگرمی را پیدا کند. بسیار پیش آمد که حتی با وجود فناوریهای جدید، ساختمان تقریبا دو برابر وزن ضروری را نیز تحمل میکرد.

الگر: ایجاد ظرفیت برق ۳۶ کیلووات بهازای هر رک تحسینبرانگیز است. برای تطبیق با این ظرفیت، چه رویکردهای سرمایشی را پیدا کردید و در نهایت کدام را انتخاب کردید؟

اتوود: سال ۲۰۰۵ که این مرکزداده را طراحی میکردیم و میساختیم، دوران جالبی در چرخهٔ طراحی مرکزداده بود. داشتیم از مراکزدادهٔ کمظرفیت یا با ظرفیت متوسط به مراکزدادهٔ بسیار پرظرفیت رو میآوردیم. در آن زمان هر چیزی را که بیشتر ۱۰ کیلووات داشت، بسیار پرظرفیت میدانستیم. چیزها زیادی دربارهٔ معنی و مفهوم پرظرفیتبودن و مزایای آن میآموختیم. در واقع همزمان هم طراحی میکردیم و هم تئوری مرکزدادهٔ پرظرفیت را در سایتهای دیگر و همین سایت آزمایش میکردیم.

ما در اینتل چندین نوعِ گوناگون از تجهیزات رایانشی داریم. بعضی سرورها از گروه تجهیزات خیلی مهم و حساس نیستند. اما بقیهٔ آنها یعنی سرورهای امور مالی و منابع انسانی طوری هستند که اگر از کار بیفتند، سهام مرکزداده سقوط میکند یا حقوق کارمندان قطع میشود. وقتی صحبت از تعداد زیادی سرور پرظرفیت باشد، مفاهیم و طراحی پایایی (Availability) مطلوب با حالت عادی تفاوت دارد. بیشتر سرورهای پرظرفیتِ اینتل، به اطمینانپذیری چندانی نیاز ندارند؛ مانند آنچه برای سرورهای حساس ضروری است. فقط باید کارکردشان ایمن باشد.

بدین ترتیب هنگام طراحی برای ساختن مرکزدادهٔ پرظرفیت، همیشه دراینباره فکر میکردیم. سرانجام در بررسی راهکارهای سرمایش، به این نتیجه رسیدیم که اگر هوای گرم و سرد را در عملیات مرکزداده کاملا از هم جدا کنیم و از شر نقاط داغ یا گرم راحت بشویم، در کویل برودتی حدود ۲۴ درصد بهرهوریِ مکانیکیِ بیشتر به دست میآوریم. فرض کنید هزار سرور را در اتاق ۹۳ متر مربعی بگذاریم و هزار سرور دیگر را دقیقا با همان میزان بار، در اتاق ۴۶۵ متر مربعی بگذاریم؛ یعنی همان بار اتاق اولی را در محیط وسیعتری پخش کنیم. در این مقایسه، از محیط فشردهتر و دارای ظرفیت بیشتر، حدود ۲۴ درصد بهرهوری سرمایشیِ بهتر به دست خواهد آمد. هرچه ظرفیت بیشتر باشد، بهرهوری هم بهتر خواهد بود.

در آن زمان محصولی در بازار نبود که سی و چند کیلووات بهازای هر رک را بدون استفاده از سرمایش با مایع خنک کند که بسیار هم گران بود. برای حل این مشکل ما رکهای هواکشدار را طراحی کردیم که امروز در بازار هست و تولیدکنندگان مختلف عرضه میکنند. با اینکه آن را برای سایت خودمان طراحی کرده بودیم تا این نیاز را برطرف کند، تصمیم گرفتیم حق امتیاز انحصاری برای این اختراع دریافت نکنیم تا آزادانه به صنعت راه پیدا کند و تولید شود. متوجه شدیم که این راه بسیار خوبی برای کنترل کامل هوا و جلوگیری از درهمرفتن هوای گرم و سرد است. امروزه این کار را میتوان از طریق دالان بستهٔ هوای گرم یا رکهای دارای هواکش انجام داد. حالا برای این کار چندین راهکار وجود دارد. ولی آنوقت برای حل این مشکل راهی نبود؛ ما خودمان رک هواکشدار را و این فضای پیرامون آن را طراحی کردیم. امروز در این مرکزداده اگر میان این چند هزار سرور راه بروید که در فضای بسیار کوچک جا گرفتهاند، خواهید دید که هیچ نقطهٔ گرم یا داغی در سالن وجود ندارد و بهخوبی مهار شده است.

تصویر: کابلکشی ساختیافته و زیرساخت الکتریکی مرکزدادهٔ اینتل، سقفی اجرا شده است.

طراحی تجهیزات مکانیکی طوری انجام شد که هوا بهطور کامل کنترل شود و در اتاق هیچگونه نشتیِ هوای داغ یا گرم نداشته باشیم. یعنی بیشترین ظرفیت را داشته باشیم تا داغترین هوا به کویل برگردد. بهجای ترکیب هوای داغِ سرورها با هوای سرد بیرون (پیشسرمایش)، میخواهیم هوایی که به کویل میرود، بیشترین دمای ممکن را داشته باشد تا بهترین بهرهوری به دست آید. دراینباره تلاشهایی زیادی کردیم. بیشک این بیشترین میزان ظرفیتی بود که تا آن زمان اجرا کرده بودیم. در حقیقت از پنج سال پیش تا حالا بهجز چند ابررایانه، هنوز هم بیشترین ظرفیتی است که تاکنون داشتهایم. این کار خیلی موثر بود و برای ما بسیار خوب کار کرد.

تصویر: در مرکزدادهٔ اینتل در ریو رانچو، کابلکشی ساختیافته از طریق سینی کابل و از راه سقف به رکها میرسد.

الگر: در طراحی این مرکزدادهٔ چنین پرظرفیت، چرا کف کاذب به کار نبردید؟

اتوود: استفاده از کف کاذب دلایل گوناگون دارد. اما هدف اصلی از بهکاربردن آن، رساندن درستِ هوا به قسمتهای درست سالن است؛ برای اینکه نقاط داغ مدیریت شود. ما در اینجا اصلا نقاط داغ نداریم؛ چون هوا را کامل و صد درصد کنترل میکنیم و هیچ نمیگذاریم هوای گرم وارد سالن بشود. اگر هوای سالن را خوب کنترل کنید، میتوانید هوای سرد را به هرجا از سالن که بخواهید بیاورید و پول خرج کف کاذب نکنید. تا وقتیکه در سالن سرور هوای سرد کافی دارید، اگر حجم آن با حجم هوای گرمِ خروجی از سرورها تناسب داشته باشد، دیگر فرقی نمیکند که این هوای سرد را از کجا وارد سالن بکنید. ما برای سادگی و سرعت در کار، تمام کابلکشی شبکه و برق را سقفی اجرا کردهایم.

الگر: دمای عملیاتی مرکزداده را در چه درچهای نگه میدارید؟

اتوود: در آن زمان ما از روش مرسوم پیروی میکردیم؛ پس دمای تعیینشده در طراحی بهگمانم حدود ۲۲ درجه سانتیگراد بود. البته شیوهٔ کارمان با امروز فرق میکرد و در آینده هم با امروز فرق خواهد کرد.

با آزمایشهایی که در این سایت با سرمایش طبیعی انجام دادیم و موارد دیگری که منتشر هم کردهایم، اکنون دیگر میدانیم که دمای ۲۲ درجهٔ سانتیگراد ضرورت ندارد. فناوری تجهیزات امروزی در برابر گرمای بیشتر از این هم بسیار مقاوم است؛ ما اکنون نقاط داغ نداریم. در واقع میخواهیم به میانگین دمای ۲۷ الی ۳۱ درجه سانتیگراد برسیم. میدانیم که امروزه از نظر فناوری میتوانیم در ۳۲ درجه هم بهخوبی کار کنیم و حتی میتوانیم به ۳۷ درجه هم برسیم. اما میان ریسک و کنترلهای محیطی و تعداد افرادی که قرار است در مرکز کار بکنند، تناسبی وجود دارد. ما میدانیم که همین الان هم سالنها را بیشتر از آنچه لازم است خنک میکنیم؛ اما با وجود بعضی سختافزارهای قدیمی، افزودن به دمای سالن زیان ویژهای در پی دارد. آنوقت که مرکزداده را میساختیم، خنکتر هم رایج بود. ما تصمیم گرفتهایم اینطور کار نکنیم و دمای عملیاتی را کمی افزایش بدهیم.

میتوانم امروز به همان سالن بروم و دما را تا ۳۴ یا ۳۵ درجه افزایش بدهم. سرورها بهخوبی کار خواهند کرد، هیچ مشکلی پیش نخواهد آمد، میزان خرابی هم افزایش نخواهد یافت. ما خیلی از این بابت مطمئن هستیم. همچنین با این کار در مصرف برق تجهیزات مکانیکی هم صرفهجویی بسیار زیادی به دست میآوریم. مشکل در اینجا با فناوریهای قدیمیتر است و حتی تجهیزاتی که از نسلهایی دو سال پیش هستند. اگر دما را بالا ببرید، فن سرورها سریعتر میچرخند و مصرف برق را افزایش میدهند. بدین ترتیب مصرف برق از آن مقداری که در تاسیسات صرفهجویی میشود، بیشتر خواهد شد. اکنون میبینید که وضعیت برای ما در حالت متعادل است. در فناوری جدید، فنها اینقدر سریع نمیچرخند و اینهمه هوا جابهجا نمیکنند. ما که نمیخواهیم برای یک دلار صرفهجویی ۱٫۵ دلار در جای دیگر خرج کنیم. میخواهیم بسته به فناوریهایی که استفاده میکنیم، در مصرف برق سالن سرور تعادل و توازن برقرار کنیم.

الگر: فرض کنید مشکل چرخش سریعتر فنها را نداشتید. در این صورت آیا ۳۶ کیلووات و دماهای عملیاتیِ بیشتر از ۳۲ تا ۳۷ درجه سانتیگراد را آستانه حداکثری در نظر میگیرید، یا پیشبینی میکنید که این مقدار در آینده بیشتر هم خواهد شد؟

اتوود: بیشک پیشبینی من این است که از مقدار امروزی بیشتر باشد. اگر به راهبرد مرکزدادهٔ اینتل توجه کنید و به جایگاهی که از نظر خودمان به آن خواهیم رسید و جایگاهی که میدانیم از نظر تولید تراشه به آن دست خواهیم یافت نگاه کنید، قطعا میبینید فضایی که سرورهایمان در سطح جهان اشغال میکنند، با افزایش نیازهای رایانشی ما بهمیزان چشمگیری کاهش مییابد. بدین ترتیب این پیشرفتی است که در دو مسیر مخالف به دست میآید. بسیاری از نیازهای مربوط به رشد و توسعه از اینجا ناشی میشود که ادارات عمومی و شرکتها، به این کار روی آوردهاند که از طریق مجازیسازی و فناوری ابر، درصد استفاده از کامپیوترهای خود را بهینه کنند. مثلا بهجای داشتن هزار سرور اداری که درصد استفادهٔ بهینه از آنها ۱۰ درصد است، شاید بتوان با بهرهگیری از مجازیسازی کمتر از صد سرور داشت. صد سروری که درصد استفادهٔ بهینهٔ بسیار خوبی دارند؛ در حالی که بهطور کلی بهازای هر CPU، فضا و مصرف کلی برق آنها کمتر است. بدین ترتیب معتقدیم در کسبوکار ما از منظر طراحی که حدود ۷۰ هزار سرور را شامل میشود، ظرفیت محیطهای پرظرفیتتر که از جدیدترین فناوری بهره میبرد، پیوسته بیشتر و بیشتر میشود، فضای سرورها کوچکتر میشوند، در همین حال کل مصرف برق کمتر و کمتر میشود.

الگر: به نظر شما صنعت مرکزداده بهسوی استفاده از تاسیسات چنین پرظرفیت خواهد رفت؟

اتوود: اگر هزینهٔ ساخت مرکزداده را از دید طراحی بر حسب متر مربع در نظر بگیرید، میبینید که توجیه ساخت مرکزدادهٔ بسیار بزرگ (مرکزدادهٔ مگا) در این صنعت دیگر سخت شده است. به نظر من قرار نیست هر شرکتی مرکزدادهٔ ۲ هزار متر مربعی بسازد، مگر آنکه یکی از آن معدود شرکتهایی باشد که مرکزدادهٔ عظیم میسازند. چنین شرکتهایی شاید تنها نیم درصد از کل شرکتها باشند.

خیلی پیش آمده من به شرکتهایی از سراسر جهان مشاوره دادهام که در پی ساختن مرکزدادهٔ ۵ هزار متری یا ۷ هزار متری بودهاند. معمولا بعد از اینکه برایشان وقت گذاشتهام و الگویی را که خودمان از آن استفاده میکنیم نشان دادهام، آنها اندازهٔ مرکزدادهٔ طراحیشدهٔ خودشان را به یک چهارم کاهش دادهاند. این کار از نظر عملیاتی بسیار کارآمدتر است. هم هزینهٔ سرمایهای اول ساخت را کاهش میدهد، هم هزینهٔ عملیاتی مرکزداده را در بلندمدت کم میکند. خلاصه اینکه صرفهجویی زیادی به دست میآید. دیگر نمیشود با این رویکرد و این میزان صرفهجویی، افراد را راضی کرد که چنین مرکزدادهٔ بسیار بزرگ و کمظرفیتی بسازند.

«اگر هزینهٔ ساخت مرکزداده را از دید طراحی بر حسب متر مربع در نظر بگیرید، میبینید که توجیه ساخت مرکزدادهٔ بسیار بزرگ (مرکزدادهٔ مگا) در این صنعت دیگر سخت شده است.»

الگر: آیا خطر گسیل گرمایی (Thermal Runaway) با افزایش ظرفیت بیشتر میشود؟ چون در این صورت اگر بخشی از سیستم از کار بیفتد، تجهیزات سریعتر گرم میشوند. شاید هم به نظر شما در بیشتر مراکزداده، زمان تحمل گرمای بدون تجهیزاتِ سرمایشی چند ثانیه بیشتر نیست؟

اتوود: سوال بسیار خوبی است. ما خیلی زود با این مسئله در محیطهای پرظرفیت روبهرو شدیم. اگر مرکزداده را با شیوهٔ بسیار سنتی خنک کنید، گسیل گرمایی بیشک مشکلی است که باید در نظر بگیرید. با این حال راههای بسیاری برای کاهش از آسیب آن وجود دارد.

تصویر: مرکزدادهٔ اینتل در ریورانچو ۸ مگاوات ظرفیت برق دارد.

به نظر من آنچه شاهدش هستیم این است که اگر مرکزداده را پرظرفیت بسازید و روشهای سرمایشیِ جایگزین مانند سرمایش با هوای طبیعی داشته باشید، این مسئله دیگر مشکل بزرگی نخواهد بود. چون سازوکار عادیِ سرمایش هوای مرکزدادهٔ شما در حال تکامل است. اما اگر سعی کنید برای مرکزدادهٔ پرظرفیت از سرمایش سنتی استفاده بکنید، مشکل بزرگی خواهید داشت که باید آن را در نظر بگیرید. وقتی این فرایند را در مراکزدادهٔ خود در سراسر جهان به کار میبردیم، دچار اشتباههایی شدیم. چیزهایی که اکنون یاد گرفتهایم، حاصل توجه به این اشتباهها و مشکلاتی است که پیش آورده بودند. وقتی در فضای خیلی کوچکی که هزاران سرور را در آن جا دادهاید، کل سیستم سرمایش از کار میافتد، بهسرعت وضعیت برای گسیل گرمایی مهیا میشود.

الگر: شما از سرمایش با مایع استفاده کردهاید و میزانی از ظرفیت برق را به کار بردهاید که معمولا در آن به فکر استفاده از سرمایش با مایع میافتند. به نظر میرسد مسئلهٔ هزینه یکی از نگرانیهای شما بوده است. آیا عوامل دیگری نیز بودند که باعث شوند بهجای سرمایش با مایع از سرمایش با هوا استفاده کنید؟

اتوود: در ابتدا افراد فکر میکردند برای هر مقدارِ بیشتر از ۱۰ کیلووات باید از راهکارهای سرمایش با مایع استفاده کرد؛ ولی بسیار گران درمیآمد. ما میدانستیم که با ساختن مرکزدادهٔ پرظرفیت مبلغ زیادی صرفهجویی میکنیم؛ اما نمیخواستیم از نظر عملیاتی در سرمایهگذاریِ اولیه ولخرجی کنیم. به همین دلیل میبایست تعادل دما را با راهکاری ارزانتر برقرار میکردیم. در هنگام طراحیِ رکهای هواکشدار که دستکم از طراحی آنها بسیار مطمئن هستیم، فهمیدیم با سرمایش کاملا طبیعی و بینیاز از گردش هوای فنها میتوانیم حدود ۳۰ کیلووات را خنک کنیم. بسیاری از راهکارها در داخلِ هواکش فن تعبیه میکنند. ما هیچکدام از این راهکارها را استفاده نمیکنیم؛ چون ریسک را افزایش میدهند و برق بیشتری مصرف میکنند. مدیریتکردن کامل هوا با بهرهگرفتن از رکهای هواکشدار یا دالان هوای گرم بسته، برای سرمایش ظرفیتِ کمتر از ۳۰ کیلووات بر رک کافی است.

راهکارهای مضاعفِ استفاده از هواکش و دالان هوای گرم بستهٔ کنترلشده، دستیافتن به ظرفیت بیش از ۳۰ کیلووات را نیز میسر میکند. در این روش تمام هوای برگشتی از رکها را اول به اتاقکی میفرستند تا کل آن با هوای بیرون ترکیب یا جایگزین شود. معتقدم صنعت مرکزداده در آینده از ظرفیت بیش از ۳۰ کیلووات بهخوبی بهره خواهد برد؛ اگر با هوایی که از سرورها خارج میشود سنجیده رفتار کند. بعضی از شرکتها همهٔ این هوا را از تاسیسات بیرون میفرستند. در واقع میتوان گفت هیچ محدودیتی در گوناگونیِ راهکارهای عملی وجود ندارد. تا وقتی راهکاری که انتخاب میکنید آثار مخرب زیستمحیطی نداشته باشد یا منجر به ذوبشدن کابلهای پشت سرور نشود، هیچ مشکلی پیش نخواهد آمد.

الگر: طراحی و بازسازی ساختمان چقدر طول کشید؟

اتوود: مرحلهٔ طراحی ساختمان حدود ۷ ماه طول کشید. بیشتر وقت ما صرف بازمهندسیِ این ساختمان شد. نقشههای کهنهٔ بیست سال پیش را بررسی میکردیم و کیفیت بسیاری از سیستمهای قدیمی موجود در محل را میسنجیدیم تا ببینیم از قبل چه داریم و اکنون برای بهوجود آوردن مرکزدادهٔ با عملکرد مطلوب و پرظرفیت به چهچیزی نیاز داریم. کل پروژه یعنی از ایده و طراحی تا سرمایهگذاری و اتمامِ پروژه و راهاندازی، در حدود ۲۰ ماه طول کشید.

الگر: در روند ساختوساز اتفاق غافلگیرکننده یا چالشی رخ داد؟

اتوود: از نظر من بیشتر مسائل و اتفاقاتِ غافلگیرکنندهای که با آنها روبهرو شدیم، مسائل عادیِ پروژهٔ ساختوساز بودند. بیشتر ناشی از این بود که میخواستیم کارخانهای را که برای ظرفیت بسیار کم طراحی شده بود، به ساختمان مناسب برای ظرفیت برق بسیار زیاد و سرمایش کافی تبدیل کنیم. مسائلی بودند از قبیل گذاشتن چیلرهای مناسب در مکان مناسب، توزیع مناسب هوا در جاهای درست، همچنین اینکه چطور برق کافی را به هر رک برسانیم تا از ظرفیت زیاد پشتیبانی کند. فقط چند چالش عملیاتی وجود داشت که آنها هم از نظر من مشکلات چندان بزرگی نبودند. با این حال برای راهاندازی این ساختمان قدیمی که برای کار ما ساخته نشده بود، با مشکلاتی روبهرو بودیم که برای حل آنها ناچار شدیم در کار تصمیمهای زیادی بگیریم.

الگر: اگر به عقب برمیگشتید و مرکزداده را دوباره طراحی میکردید، کاری بود که بخواهید جور دیگری انجام بدهید؟

اتوود: هرکاری را باید در قالب زمانی خودش دید. برای نمونه توزیع برق؛ در آن زمان هیچکس در مرکزدادهاش چنین مقدار ظرفیتی را اجرا نمیکرد و در نتیجه نمیشد آنطوری که نیاز داشتیم برقرسانی به رکها را انجام بدهیم. مجبور شدیم گاهی با تولیدکنندگان و گاهی با تامینکنندگان تعامل کنیم. از این کار خیلی خوشمان نمیآمد؛ ولی به هر حال این کار را کردیم چون میخواستیم به آن ظرفیتی که میخواهیم برسیم. بازار تجهیزات پرظرفیت در آنوقت تقریبا تازه به وجود آمده بود. به همین دلیل با همان چیزهایی کار کردیم که در اختیار داشتیم، یا امکان بهدستآوردنش را داشتیم. با این توضیح نمیتوانم بگویم حتما کارها را جور دیگر انجام میدادیم. زمان و موقعیت بهگونهای بود که بسیاری از محصولاتِ ویژهٔ اجرای پرظرفیت وجود نداشتند و ما در آن وقت پیشرو بودیم.

تصویر: یکی از هواسازهای مرکزداده ریورانچو

بزرگترین چالشی که از نظر طراحی و راهاندازی این ساختمان قدیمی با آن روبهرو شدیم، در ترتیبِ قرار گرفتن نوع تجهیزات در طبقات بود. معمولا کارخانهها بدین شکل هستند که طبقهٔ بالا جای تجهیزات مکانیکی است، طبقهٔ میانی جای تجهیزات تولیدی است، طبقهٔ پایین هم برای تجهیزات الکتریکی است. بدین معنی که لولهکشیِ آب در طبقهٔ بالای سرورها بود و خود سرورها و تجهیزات الکتریکی در طبقهٔ پایین قرار داشتند. بدین ترتیب میبایست مطمئن میشدیم لولهها که در طبقهٔ روی سرورها هستند، بهخوبی عایق و محکمکاری شدهاند و قابلیت تشخیص نشتی آب بهخوبی کار میکند. ما انبوهی از اتصالات برقی و جوشکاری و مفاصل لولهکشی داریم. در این چندین هزار اتصال لولهکشی، به هر حال یکوقتی نشتی رخ میدهد. پس لازم بود در همان موقع که بازسازی میکردیم، مطمئن بشویم نشتیهای احتمالی در آینده بر عملیات مرکز تاثیری نخواهند گذاشت.

الگر: دربارهٔ ظرفیت بسیار زیاد و تمام فناوریهایی که با خود میآورد، آیا فکر میکنید این راهکار فراگیر است که همهجا میتوان اجرا کرد؟ یا بعضی از این کارها خاص هستند و فقط در همین مرکزداده نتیجه دادهاند؛ شاید برای دیگران که اکنون مرکزداده طراحی میکنند مناسب نباشد؟

اتوود: سوال خوبی است. این برای ما جهش بزرگی بهسوی پرظرفیتشدن بود که به آن HPDC ـ[3] یا مرکزداده پربازده میگوییم و اکنون به استاندارد طراحی مرکزداده در سطح جهان تبدیل شده است. این استاندارد را با مجازیسازی میتوان برای سرورهای سنتیِ بیشتری استفاده کرد. به نظر من قطعا دارد در فناوریها تحولی رخ میدهد. تولیدکنندگان دارند محصولات را بهبود میبخشند و آنها را بهتر میکنند؛ بنابراین سالبهسال شاهد پیشرفت و بهبود هستیم.

الگر: پس این برای شما مطمئنا الگوی تکرارپذیر است.

اتوود: بسیار تکرارپذیر.

الگر: اگر یکی از خوانندگان این مصاحبه بخواهد مرکزدادهای بسازد که در هر رک ۵ یا شاید هم ۱۰ کیلووات نیاز داشته باشد، به نظر شما پیکربندی رکِ هواکشدار و مولفههای دیگری که شما اجرا کردهاید، هنوز طراحی مناسبی است؟ یا بر اساس هر ظرفیت برق متفاوت، مدل هم متفاوت خواهد بود؟

اتوود: من با شرکتهای مختلفی صحبت کردهام که دقیقا همان کاری را میکنند که الآن پرسیدید. بهطور کلی میبینم شرکتهایی که فرصت پیدا میکنند طراحی مرکزدادهٔ خود را تغییر بدهند، یا تاسیسات جدید بسازند، یا سرمایهگذاری خودشان را برای بهبود امکانات مرکزداده افزایش بدهند، از طراحیهای با ظرفیت بسیار زیاد استفاده میکنند که برای آنها یا از راهکار هواکش استفاده میشود یا دالان هوای گرم بسته. دربارهٔ شرکتهای با اندازهٔ متوسط حرف میزنم که ۵۰۰ تا ۵ هزار یا ۱۰ هزار سرور دارند. بیشتر آنها مرکزدادهٔ خود را تبدیل میکنند به تاسیساتی با ظرفیت بسیار بیشتر از مرکزدادهٔ ما. همان طور که پیش از این هم اشاره کردهام، کاهش هزینهٔ عملیاتی که از این شیوه به دست میآید، ناشی از بهرهوری خوب و همچنین صرفهجویی در هزینهٔ سرمایهای است.

تنها یک استثنا میتوانم دراینباره بگویم که حتی در اینتل هم هست. این استثنا بخش کوچکی از کسبوکار ما است که به راهکارهای با پایایی (Availability) بسیار خوب نیاز دارد. اطمینانپذیری برای چنین سیستمهایی حیاتی است و نباید بههیچوجه از کار بیفتند. در پیشبینی چنین موقعیتهایی، ما نمیخواهیم کارمان پر ریسک باشد. اگر همهٔ برنامهها و کامپیوترهای با موقعیت حساس را در طراحی بسیار پرظرفیت قرار بدهید، ریسکِ بیشتری در پی دارد. ما برای آن بخش کوچک از کسبوکارمان که امروزه کمتر از ۵ درصد از کل بار رایانشی ما را شامل میشود، از طراحی سنتیتر و دارای ظرفیت متوسط استفاده کردهایم. در این کار تجهیزات را کمی پخش کردهایم تا آسیبپذیری را کاهش بدهیم.

بدین ترتیب در شرکتهای دارای کسبوکارِ بسیار حساس و مهم، همانند شرکتهای سرمایهگذاری یا بانکها که در صورت قطعی ممکن است در هر ثانیه میلیونها دلار ضرر کنند، شک دارم فقط برای چند دلار صرفهجویی در سرمایهٔ اولیه، تمام سرورهای خود را در اتاقک کوچکی جا داده باشند. این شرکتها سرورهایشان را در چندین مرکزداده پخش میکنند و برای داشتن اطمینانپذیری خوب، خوشهٔ پردازشی «درحالکار ـ درحالکار» و «تکثیر نسخهٔ داده» (Replication) دارند. غیر از این تقریبا برای بیشتر ظرفیت رایانشی و انواع سنتی سرورهایی که کارشان برای کسبوکار بسیار حساس نیست، میبینیم که از فشردهسازیِ بیشتر و تصمیماتی برای انتقال به فضاهای بسیار کوچکتر استفاده میکنند؛ برای اینکه بهرهگیری از سرمایهگذاری به بیشترین مقدار ممکن برسد و بهرهوری مطلوب به دست آید.

الگر: چیزهای دیگری هم در طراحی این مرکزدادهٔ پرظرفیت آموختهاید که بخواهید دیگران را به آن توصیه کنید؟

اتوود: در گذشته ما مرکزداده را بهروش سنتی میساختیم؛ بدون اینکه بهخوبی نیازهای گستردهتر فاوا را در نظر داشته باشیم. گروه طراحی مرکزداده به مسائل فیزیکی مثل برق و سرمایش توجه داشتند. ساختمانهای ما همهشان مطابق با الگوی دقیق استفاده ساخته نشدهاند و همیشه هم طراحی بهینه نداشتهاند.

تصویر: لوله کشی آب سرد

رویکرد ما در طراحی مرکزدادهٔ پربازده این است که اتاقی را برای رایانش پرظرفیت در نظر میگیریم. هنگامی که دربارهٔ داخل مرکزداده صحبت میکنیم، دیگر «ساختمان و تاسیسات» منظور نیست بلکه سیستمهای فاوا در مرکز توجه است. ما ساختمان را هماهنگ با رایانش و ذخیرهسازی و قطعات شبکه میسازیم؛ اینها برای اجرای برنامههای کاربری لازم هستند. سعی میکنیم کل مجموعه را در یک راهکار کلی ببینیم و تمرکز کمتری بر روی هریک از قطعات و مولفههای جداگانه، از جمله خود ساختمان بکنیم. ما داریم در داشتن این نوع نگرش پیشرفت میکنیم.

الگر: این مرکزداده جای چندان زیادی اشغال نکرده است. آیا در نظر دارید که آن را گسترش بدهید؟

اتوود: اگر چهار سال پیش این سوال را از من میپرسیدید میگفتم حتما؛ در واقع برای این کار برنامههایی هم داشتم. با این حال بهدلیل داشتن ظرفیت زیاد و روند کاهشیِ نیاز به فضا که در سطح جهان در مراکزدادهٔ خود میبینیم، هرگز چندان فضایی را برای مراکزداده استفاده نخواهیم کرد. اکنون فضایی که سرورهای اینتل در سطح جهان اشغال کردهاند، کاهش چشمگیری یافته و به همان نسبت هم نیازهای رایانشی ما افزایش قابل توجهی پیدا کرده است. بزرگترین مزیت کار ما که قبلا هم در روش ساخت و عملیات و برنامهریزیِ مراکزدادهٔ اینتل بسیار به نفع ما بوده، «فناوری چندهستهای اینتل» است. فناوری چندهستهای اقدامات و نیازهایمان را تغییر داده است. ما دیگر مرکزداده را برای ظرفیت بیشتر نمیسازیم؛ فضایی که سرورهایمان اشغال میکنند دارد کوچکتر میشود. تمرکز ما بر روی آن جنبهٔ کلیتر مرکزداده است که پیشتر اشاره کردم. برای سهامداران ما سرمایهگذاریِ خوبی خواهد بود اگر بتوانیم ۵ میلیون دلار در رایانش هزینه کنیم که در عوض با این کار از صرف ۳۰ میلیون دلار هزینه برای ساختمان جلوگیری بشود.

این نقطهٔ مهم کار ما بود؛ وقتی گفتیم «دیگر موضوع فقط ساختمان مرکزداده نیست.» مرکزداده برای اینتل بهمعنای کل مجموعه است و اینکه کل مجموعه چگونه کار میکند تا MIPS ـ[4] داشته باشد. زمانی سرمایهگذاری در ساختمان مرکزداده از نظر ما خیلی معقول و منطقی به نظر میآمد. اکنون دیگر آن زمان را سپری کردهایم. این وقتی رخ داد که سه سال پیش، فناوریِ جدیدمان آماده شد و توانستیم ظرفیت رایانشی خود را بسیار افزایش بدهیم. در واقع توانستیم هزینه و فضای اشغالشدهٔ مراکزدادهٔ اینتل را با سرمایهگذاریِ درست در مکانهای درست کاهش بدهیم. به همین دلیل است که دیگر به بخش ساختمان تمرکز نمیکنیم. اکنون ساختمان از نظر ما جزئی از اجزای کل مجموعه است.

الگر: این موضوع خود را چگونه در طراحی نشان داده است؟ بیشتر شرکتها تاسیسات مرکزدادهٔ خودشان را بهگونهای طراحی میکنند که خیلی قابل اطمینان و در عین حال مجموعهای از اجزای جدا از هم باشد. اینکه شما مجموعهٔ مرکزداده را کل واحد در نظر میگیرید، چه تاثیری بر طراحی فیزیکی دارد؟

اتوود: واقعا سوال خوبی است. کمی طول کشید تا این موضوع خوب دستمان بیاید. حدود ۷۰ درصد از طراحی رایانشِ فاوای ما مبتنی است بر نسل بعدی تراشهها. ما هم درست مانند تولیدکنندگان ماشین و هواپیما کار میکنیم که طرحهای اولیه را قبل از تولید محصولاتشان با نرمافزار شبیهسازی میکنند؛ یعنی کار را پیش از ساختن هر تراشه، بر اساس مدلسازی بنا میکنیم.

ما از همان ابتدا الزامات کسبوکار یا الزامات رایانشی خود را میسنجیم و آن را با دانشی تلفیق میکنیم که از ظرفیت زیاد داریم. اکنون میتوانیم ایکس عدد هسته را در هر رک قرار بدهیم؛ پس به تعداد زیادی رک نیاز داریم تا الزامات طراحی را برآورده کنیم. ما مرکزداده را بر اساس نیاز میسازیم. اینطوری نیست که ابتدا ساختمان را بسازیم بعد ببینیم در ده سال آینده چهچیزی در آن خواهیم گذاشت. اول چیزهایی را که نیاز داریم تعیین میکنیم، بعد با داشتن ذهنیت روشن در سطح برنامهٔ کاربر، مرکزداده را بر اساس نیاز میسازیم. هدف را سهساله تا پنجساله تعیین میکنیم؛ مرکزداده را بیستساله نمیسازیم چون فناوری بهسرعت تغییر میکند. کوشش میکنیم نسبت به تغییرات، بسیار سازگاری باشیم. به نظرم این موضوع به نکتهٔ اصلیِ کار ما برمیگردد. اینکه مرکزداده را ماژولار میسازیم تا هزینهٔ مناسب و تغییرپذیریِ سریع به دست آوریم. فناوری در این کار با سرعت بسیار زیادی تغییر میکند؛ نمیشود امروز مرکزدادهای بسازیم که ده سال دیگر هم نیازهای ما را برآورده کند. به همین دلیل است که ترجیح میدهیم مراکزدادهٔ کوچکتری بسازیم که محدود به تامین نیازهای امروز باشد. پنج سال دیگر که فناوری تغییر کرد، زمانی که میدانیم مثلا تراشههای ۲۰۱۵ و تراشههای ۲۰۲۰ چه شکلی خواهد بود، مرکزدادهٔ کوچک یا متوسط دیگری، مثلا ۷۵۰ متر مربعی میسازیم. هدف طراحی ما باید بر اساس زمان کارِ کامل مجموعه باشد؛ چون ساختوساز بیش از اندازه، هزینهٔ زیادی دارد و از طرفی ساختوساز کم هم آسیبپذیری پیشبینینشده در پی دارد. وقتی مرکزداده را یک مجموعه واحد در نظر بگیرید، میتوانید از روشهای گوناگون بسیاری به اطمینانپذیری دست پیدا کنید…

الگر: … هرکجا هم که لازم باشد عملیات بازسازی فناوری را روی ماژولهای مرکزداده انجام میدهید.

آتوود: آفرین! دقیقا همین طور است.

الگر: آموختنیهای دیگری هم هست که بخواهید دربارهٔ پروژهٔ این مرکزداده بگویید؟

اتوود: یکی از آن موضوعات جالبی که در طول ساخت این مرکزدادهٔ شِبه کلاس دو به آن پی بردهایم، این بود که طراحی قدرتمند و کمهزینه، اطمینانپذیری بهتر را میسر میکند. ما در این پنج سال بههیچوجه ازکارافتادگی نداشتهایم. گمانم بالاخره زمانی در جایی پیش خواهیم آمد؛ ولی آنچه که از نتایج فعالیت خود در سطح جهانی درمییابیم، این است که میتوانید مرکزداده را بسازید بدون اینکه همهٔ اجزایی را که به نظر لازم میآید در اختیار داشته باشید. با هوش و دانش بیشتر میتوان این کار را بهروش دیگری انجام داد و بدون صرف هزینهٔ اضافه به پایایی (Availability) مطلوب دست یافت.

ما داریم دو مرکزدادهٔ شِبه کلاس دو میسازیم و عملکردهای کلاس چهار را از آنها به دست میآوریم. این برایمان خیلی مطلوب است؛ چون در عین حال که زیاد هزینه صرف نمیکنیم، آن اطمینانپذیری را که میخواهیم، همیشه از سرمایهگذاری در کلاس پایینتر به دست میآوریم.

«ولی آنچه که از نتایج فعالیت خود در سطح جهانی درمییابیم، این است که میتوان مرکزداده را ساخت بدون اینکه همهٔ اجزایی را که به نظر لازم میآید در اختیار داشته باشید. با هوش و دانش بیشتر میتوان این کار را بهروش دیگری انجام داد و بدون صرف هزینهٔ اضافه به پایایی مطلوب دست یافت.»

پانویس

[1] این مطلب ترجمهٔ بخش سیزدهم از کتاب «The Art of the Data Center» است. گفتوگوکننده داگلاس الگر (Douglas Alger)، مترجم پرواز خیّر، ویراستار پرهام غدیریپور، بهکوشش دکتر بابک نیکفام، تهیهشده در باشگاه مراکزداده.

[2] Very Early Smoke Detection Apparatus

[3] High Performance Data Centers

[4] چند میلیون فرمان در ثانیه (Millions of Instructions Per Second)

درج دیدگاه